Last Updated on 15 maart 2025 by connectyourworld

Besteed u als SEO expert ook blijvende aandacht aan het crawlen en de Google indexering van uw website? Zodra een site namelijk live is of voorbij een bepaalde leeftijd is, leert de ervaring, dat de meeste webmasters of SEO specialisten zich niet meer bezig met hun crawlbudget. Zolang u echter op een bepaald punt in uw website blijft linken naar nieuwe blog posts, moeten deze gewoon in de index van Google of Bing worden weergegeven en gerangschikt.

Een SEO expert kan bijvoorbeeld de webmaster ondersteunen met technische SEO als deze SEO kennis niet aanwezig is bij de webmaster. Door aandacht te schenken aan de indexatie van uw website in Google, bent u tijdig op de hoogte, als er iets niet goed gaat op uw website. Dit helpt u uw website stapsgewijs te verbeteren.

Estimated reading time: 10 minuten

Alleen na verloop van tijd merkt u, dat uw website begint met dalen in de rankings op specifieke relevante SEO zoekwoorden combinaties. Geen van de nieuwe berichten haalt zelfs de top 100 van het doel zoekwoord. Het kan echter gewoon een gevolg zijn van de technische structuur, te dunne content of nieuwe algoritme wijzigingen. Het kan echter ook worden veroorzaakt door een zeer problematische crawlfout. Met honderden miljarden webpagina’s in de index van Google moet u uw crawlbudget optimaliseren om concurrerend te blijven. Hier volgen 11 tips en trucs van onze SEO expert om uw crawlsnelheid te optimaliseren. Op deze wijze gaan uw webpagina’s hoger scoren in de zoekresultaten. Daardoor is de kans, dat u bovenaan in Google komt een stukje groter.

Fouten in uw crawlstatus kunnen wijzen op een dieper probleem op uw website. Het controleren van uw crawlstatus om de 30-60 dagen is belangrijk om mogelijke fouten te identificeren. Deze fouten kunnen namelijk van invloed zijn op de algehele marketingprestaties van uw site. Het is letterlijk de eerste stap van SEO optimalisatie door een SEO expert. Zonder deze stap zijn alle andere pogingen van nul waarde. Als u nu de toegang tot een bepaalde webpagina wilt verwijderen, kunt u Google Search Console dit direct laten weten. Dit is handig als een pagina tijdelijk wordt omgeleid of een 404 fout bevat. Een 410 parameter verwijdert een pagina permanent uit de index. Dus pas op voor het gebruik van de nucleaire optie.

Als uw website een crawlfout ervaart, kan het een eenvoudige oplossing vereisen of een indicatie zijn van een veel groter technisch probleem op uw site. De meest voorkomende crawlfouten zijn bijvoorbeeld:

Om een aantal van deze fouten te diagnosticeren, kunt u gebruikmaken van de tool ‘Fetchen als Google’ om te zien hoe Google uw site effectief bekijkt. Het niet correct ophalen en weergeven van een pagina kan een aanwijzing zijn voor een diepere DNS fout, die door uw DNS provider moet worden opgelost. De meest voorkomende fouten zijn bijvoorbeeld:

Meestal is een serverfout tijdelijk. Hoewel een hardnekkig probleem ertoe kan leiden, dat u rechtstreeks contact moet opnemen met uw hostingprovider.

Robots.txt fouten kunnen echter problematischer zijn voor uw site. Als uw robots.txt-bestand een 200- of 404-fout retourneert, betekent dit, dat zoekmachines problemen hebben dit bestand op te halen. U kunt een robots.txt-sitemap verzenden of het protocol helemaal vermijden. Daarbij kiest u ervoor om handmatig no index-pagina’s te gebruiken, die een probleem kunnen vormen voor uw crawl. Als u deze fouten snel oplost, zorgt u ervoor, dat al uw doelpagina’s worden gecrawld en geïndexeerd wanneer zoekmachines uw site de volgende keer crawlen.

Met de komst van de ‘mobile-first index’, moeten we ook onze pagina’s optimaliseren om mobielvriendelijke kopieën weer te geven op de mobiele index. Het goede nieuws is, dat een desktopkopie daarom nog steeds wordt geïndexeerd en wordt weergegeven onder de mobiele index, als er geen mobielvriendelijke kopie bestaat. Het slechte nieuws is, dat uw SEO rankings hieronder kunnen lijden. Er zijn namelijk veel technische opties, die uw website meteen mobielvriendelijker kunnen maken, waaronder:

Test uw website op een mobiel platform en voer het uit via ‘Google Pagespeed Insights’. Website snelheid is dus een belangrijke SEO ranking factor en kan van invloed zijn op de snelheid, waarmee zoekmachines uw website kunnen crawlen.

Zoekmachines zullen uw website namelijk vaker crawlen, als u regelmatig nieuwe content produceert en verouderde content update. Dit is vooral handig voor uitgevers, die regelmatig nieuwe verhalen moeten publiceren en indexeren. Regelmatig goede content creëren geeft bijvoorbeeld signalen aan zoekmachines. De zoekmachines zien namelijk, dat uw website voortdurend wordt verbeterd met engaging content en ook regelmatig van nieuwe content wordt voorzien. Op deze wijze geeft u een signaal af, dat uw website daarom vaker moet worden doorzocht om het beoogde publiek te bereiken.

Eén van de beste tips voor indexering tot op heden is het verzenden van een Google sitemap naar Google Search Console en Bing Webmaster Tools. U kunt bijvoorbeeld een XML versie maken met behulp van een sitemapgenerator. Of u kunt een handmatige XML versie maken door de canonieke versie van elke pagina met duplicated content te taggen.

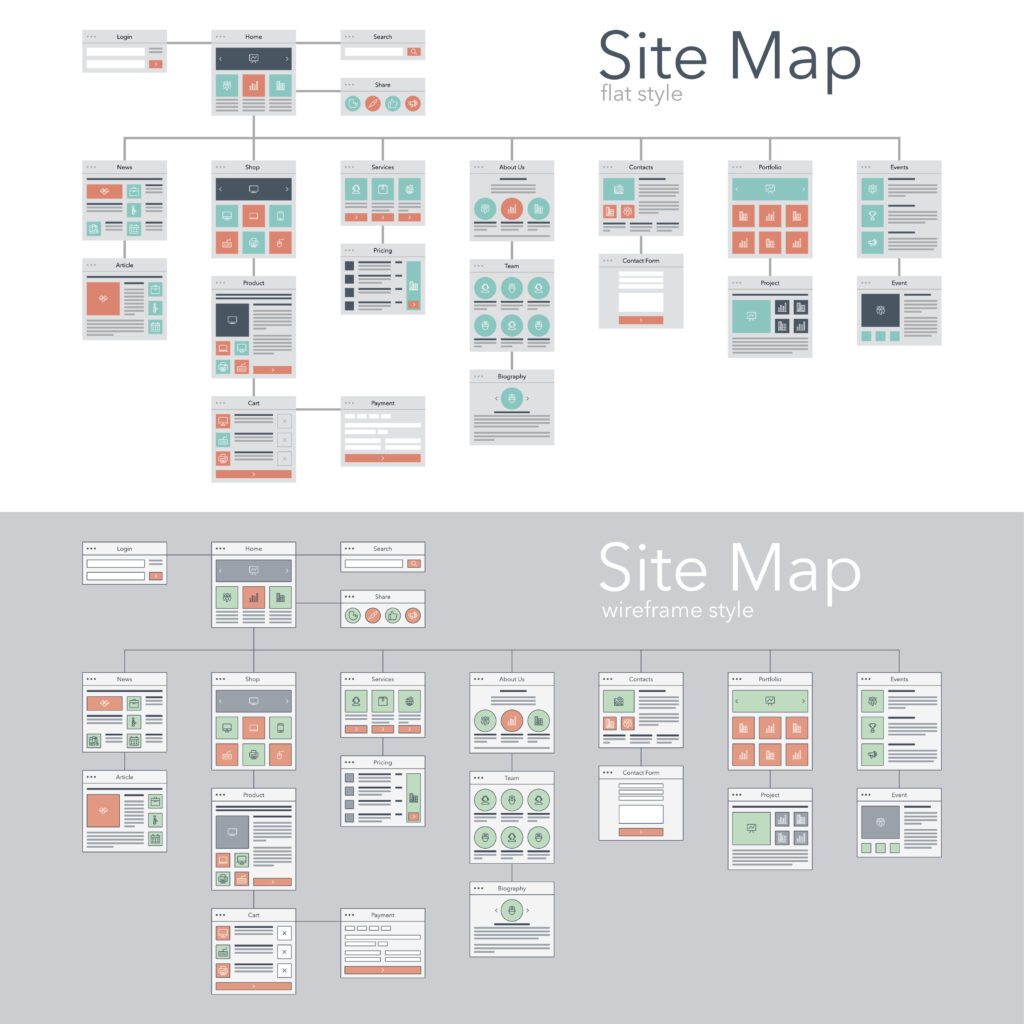

Het opzetten van een consistente informatiearchitectuur is cruciaal om ervoor te zorgen, dat uw website niet alleen goed wordt geïndexeerd, maar ook goed is georganiseerd. Door hoofddienst categorieën te maken waar gerelateerde webpagina’s geplaatst worden, kunnen zoekmachines beter indexeren. Op deze wijze wordt de intentie van een pagina duidelijker voor een zoekmachine.

Als een webpagina op uw site of een sub domein afzonderlijk wordt gemaakt, heet dit een verweesde pagina. Het kan ook zijn, dat er een fout optreedt, waardoor deze niet kan worden gecrawld. U kunt deze indexeren door een koppeling op een extern domein te verkrijgen. Dit is een bijzonder nuttige strategie om nieuwe stukken content op uw website te promoten en sneller te laten indexeren. Schakel daarvoor wel een SEO expert in.

Als u zoekmachines dwingt grote en niet geoptimaliseerde afbeeldingen te crawlen, wordt uw crawlbudget opgeslokt. Uw website wordt dan helaas niet zo vaak geïndexeerd. Zoekmachines hebben ook moeite met het crawlen van bepaalde backend elementen van uw website. Google heeft bijvoorbeeld in het verleden moeite gehad om Javascript te crawlen. Zelfs bepaalde bronnen zoals Flash en CSS kunnen slecht presteren op mobiele apparaten en uw crawlbudget opeten. In zekere zin is het een verlies-verlies scenario, waarbij men pagina snelheid en crawlbudget opoffert voor opdringerige elementen op de pagina. Zorg ervoor, dat u uw webpagina optimaliseert voor snelheid. Dit kan vooral voor mobiel, door resources op de pagina te verkleinen, zoals CSS. U kunt ook ‘caching en compressie’ inschakelen. Dit helpt spiders uw website sneller te crawlen.

In de loop van de ontwikkeling van uw website kan het zinvol zijn om een noindex-tag te implementeren op pagina’s, die mogelijk gedupliceerd zijn of alleen bedoeld voor gebruikers, die een bepaalde actie ondernemen. Hoe dan ook, u kunt webpagina’s identificeren met noindex-tags en zo voorkomen, dat ze worden gecrawld door een gratis online tool zoals Screaming Frog. Met bijvoorbeeld de Yoast-plug-in voor WordPress schakelt u eenvoudig een pagina om van index in noindex. U kunt dit ook handmatig doen op de backend van pagina’s op uw site.

In de oude versie van Google Search Console kunt u de snelheid van uw crawlsnelheid eigenlijk vertragen of aanpassen als de spiders van Google een negatieve invloed hebben op uw website. Dit geeft uw website ook de tijd om de nodige wijzigingen aan te brengen, als deze een belangrijk herontwerp of migratie ondergaat.

Het hebben van enorme hoeveelheden duplicated content kan uw crawlsnelheid aanzienlijk vertragen en uw crawlbudget opeten. U kunt deze problemen oplossen door te voorkomen, dat deze pagina’s worden geïndexeerd. Dit kan door een canonieke tag op de pagina te plaatsen, die u wilt indexeren. In dezelfde lijn loont het om de metatags van elke afzonderlijke pagina te optimaliseren. Dit voorkomt namelijk, dat zoekmachines vergelijkbare pagina’s als duplicated content in hun crawl verwarren.

Er kunnen gevallen zijn waarin u wilt, voorkomen dat zoekmachines een specifieke pagina crawlen. U kunt dit bijvoorbeeld op de volgende manieren doen:

Dit kan ook helpen om uw crawls efficiënter uit te voeren, in plaats van zoekmachines te verplichten duplicated content in te voeren. Als uw website slecht wordt weergegeven in Google, zijn er nog diverse andere opties waar dat aan zou kunnen liggen.

Herman Geertsema is de eigenaar van Connect your World, een SEO bureau in Den Haag. Hij is een ervaren SEO expert en Content Marketeer.

Bij Connect your World kunt u ook een SEO consultant inhuren in de volgende regio´s:

Heeft u een vraag voor ons of wilt u ons als SEO specialist inhuren? Surf naar onze Contact pagina en bel of mail ons.

Met deze SEO checklist gaat de vindbaarheid van uw website met sprongen vooruit.

Op deze site vindt u ook een lijst met veelal gratis SEO tools. Hiermee kunt u alvast een start maken met de SEO optimalisatie van uw website. U kunt natuurlijk ook uw SEO laten doen. De SEO specialist weet precies hoe de indexering in Google van uw website precies in zijn werk gaat.