Last Updated on 1 juli 2024 by connectyourworld

SEO Optimalisatie kan grofweg worden onderverdeeld in drie takken: On-page SEO, Off-page SEO en Technische SEO. On page SEO draait om de inhoud en HTML tags. Off-page SEO bestaat voornamelijk uit backlinks. Terwijl technische SEO in gaat op de toegankelijkheid van uw website. Technische SEO wordt vaak gezien als een van de moeilijkste onderdelen van SEO. Schakel daarom altijd een technische SEO specialist in als u vraagstukken heeft op het gebied van SEO techniek.

Technische SEO, ook bekend als technische zoekmachineoptimalisatie, verwijst naar de praktijk van het optimaliseren van de technische aspecten van een website om de zichtbaarheid en rangschikking in zoekmachines zoals Google te verbeteren. Het richt zich op het verbeteren van de infrastructuur, codering en prestaties van een website om zoekmachines te helpen de content beter te begrijpen, te indexeren en te waarderen.

Technische SEO omvat alle optimalisaties, die aan de backend van een website worden gedaan om de zoekmachine-indexering en -crawlbaarheid te verbeteren. Dit omvat het verbeteren van de laadsnelheid van de website, zorgen voor mobielvriendelijkheid en het optimaliseren van de site-architectuur. Het gaat ook om het implementeren van een goed gestructureerde URL-hiërarchie en het gebruik van veilige HTTPS-verbindingen. Daarnaast omvat technische SEO het corrigeren van fouten in robots.txt en het maken van een XML-sitemap om zoekmachines te helpen de website efficiënter te crawlen. Tot slot, het oplossen van eventuele dubbele contentproblemen en het implementeren van gestructureerde gegevens (schema markup) vallen ook onder technische SEO om de zichtbaarheid in zoekresultaten te verbeteren.

Geschatte leestijd: 32 minuten

En hoewel u ze alle drie nodig heeft om goed te ranken, kunt u stellen, dat technische SEO eigenlijk op de eerste plaats komt. U moet een sterke technische basis voor uw website bouwen. Anders kan het gebeuren, dat voordat u deze met content vult en promoot met backlinks, alles in elkaar stort. In deze Technische SEO checklist concentreren wij ons op het controleren van technische problemen (SEO techniek) op uw website en het optimaliseren van uw websitestructuur. Het verbeteren van de website snelheid en de toegankelijkheid komen ook uitgebreid aan bod.

Binnen Chrome kan u gebruiken maken van diverse handige extensies, die het verbeteren van uw online marketing mogelijk maken zoals bijvoorbeeld:

In Google Chrome is het mogelijk om websites te inspecteren. Klik met uw rechtermuisknop en dan inspecteren om de code van uw website te bekijken. Je kan zien hoe de website laadt en hoe de site er

per apparaat uitziet. Daarnaast ziet u ook waar er eventueel fouten in de website zitten.

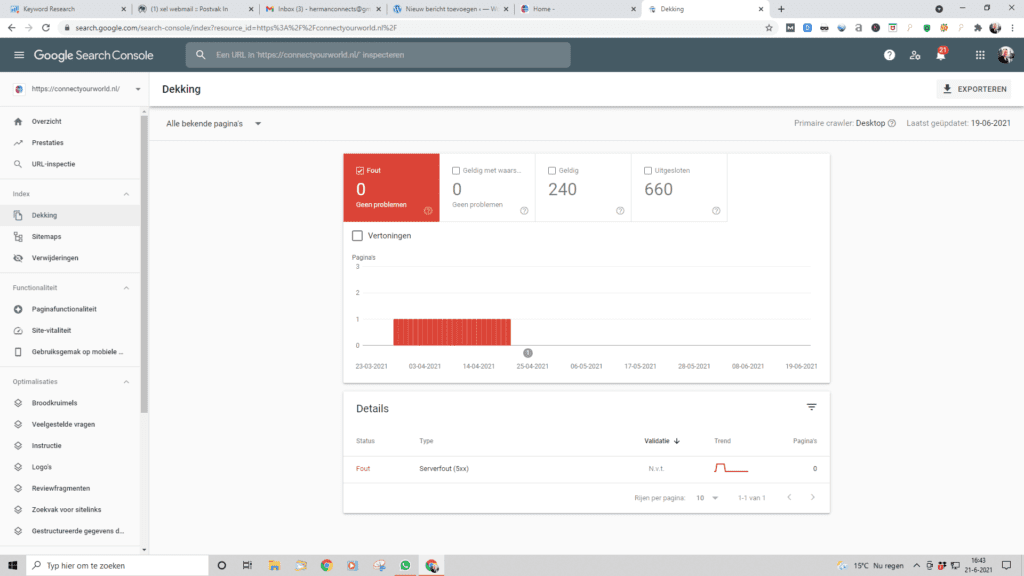

Een voor de hand liggende plek om te beginnen is om te kijken of uw website überhaupt is geïndexeerd. En met geïndexeerd bedoelen wij of het wel of niet in de zoekresultaten wordt weergegeven. Het eerste, dat u daarom hier moet doen, is uw domeinnaam googelen en uw website zoeken tussen de zoekresultaten. Staat uw website tussen de zoekresultaten? Dan is het goed. Laten we nu eens kijken hoeveel van uw website daadwerkelijk in de zoekindex is terechtgekomen. Een goede plek om dit te controleren is het dekkingsrapport in Google Search Console.

Het rapport laat zien hoeveel van uw pagina’s momenteel zijn geïndexeerd, hoeveel zijn uitgesloten en wat enkele van de indexeringsproblemen op uw website zijn. Welke tool u ook kiest, het aantal geïndexeerde pagina’s moet dicht bij het werkelijke aantal pagina’s op uw website liggen. Dus als u bijvoorbeeld een e-commerce website heeft, moet het aantal geïndexeerde pagina’s overeenkomen met het aantal producten dat u heeft geüpload.

Over het algemeen zijn er twee soorten indexeringsproblemen. Een daarvan is, wanneer een pagina niet wordt geïndexeerd, terwijl dat wel zou moeten. De andere is wanneer een pagina wordt geïndexeerd, hoewel dit niet de bedoeling is. Als u Google Search Console gebruikt om uw website te controleren, wordt het eerste type indexeringsprobleem meestal als een fout gemarkeerd:

Indexeringsfouten treden op wanneer u Google heeft gevraagd een pagina te indexeren, maar deze wordt geblokkeerd. Een pagina is bijvoorbeeld toegevoegd aan een sitemap, maar is gemarkeerd met de noindex- tag of is geblokkeerd met robots.txt . Om het probleem op te lossen, controleert u of de pagina moet worden geïndexeerd. Zo ja, verwijder dan wat het blokkeert. Zo nee, verwijder dan de pagina uit uw sitemap. Het andere type indexeringsprobleem is, wanneer de pagina wordt geïndexeerd, maar Google weet niet zeker of deze geïndexeerd moest worden. In Google Search Console worden deze pagina’s meestal als geldig gemarkeerd met waarschuwingen:

Dit soort indexeringsproblemen treden meestal op wanneer u heeft geprobeerd de pagina te blokkeren met behulp van sitemap robots txt instructies. Het is een veel voorkomende fout om te denken, dat robots.txt de indexering van de pagina kan blokkeren. In werkelijkheid staat het Google vrij om deze instructies te negeren. Als u de pagina echt wilt blokkeren, moet u de no index-tag gebruiken.

Dekkingsfouten zijn fouten, die Search Console rapporteert als verbeterpunten. Dit soort fouten kunnen impact hebben op de vindbaarheid van uw website. Ze kunnen cruciaal zijn of gewoon simpele tips, die u website net wat beter vindbaar maken. In dit artikel vertellen wij u alles over dekkingsfouten. U krijgt te horen, wat de 10 meeste voorkomende fouten zijn.

Om de dekkingsfouten terug te zien, heeft u Google Search Console tot u beschikking. U vindt de dekkingsfouten links terug onder ‘Dekking’.

U weet nu waar de dekkingsfouten staan. Daarom is het nu de hoogste tijd om het over de dekkingsfouten te hebben. Per dekkingsfout behandelen we drie dingen:

Betekenis: Een serverfout (5xx) is, zoals de naam al zegt, een probleem bij de server. Dit kunnen veel dingen betekenen. Dat er bijvoorbeeld iets tijdelijk niet werkt, dat er iets niet ondersteunt wordt of dat de server overbelast is.

Urgentie: De hoogste urgentie! Als er een 5xx-fout is, kan het zijn, dat uw pagina niet werkt. En als Google dan toevallig langskomt, bent u helemaal niet blij.

Oplossing: Omdat een serverfout zoveel oorzaken kan hebben, kunnen we u niet de precieze oplossing aanbieden. Stap 1 is om te kijken, wat u precies op de pagina ziet. Stel dat daar een 500- of een 503-fout staat, dan weet je al meer. Googel vervolgens op die term. Vervolgens schakelt u een developer in of neemt u contact op met uw hostingpartij. Vaak is het zo, dat u hier zelf niks aan kan doen of dat het een tijdelijk probleem was.

Betekenis: Wanneer er een fout is met de omleiding, dan is er een fout met een redirect. Dit kan betekenen, dat de redirect niet juist is. Het kan ook zo zijn, dat er een redirect loop is. Zo’n loop ontstaat, wanneer, uw pagina A naar pagina B doorstuurt en pagina B weer naar pagina A.

Urgentie: Ook dit moet u echt prioriteit geven. Stel, dat u net de URL van uw belangrijkste blogs hebt geoptimaliseerd, dan wilt u wel, dat doet goed gaat.

Oplossing: De redirect verwijderen, de redirect aanpassen of de redirectloop eruit halen.

Betekenis: Een ingediende URL is niks anders dan een URL, die is aangeboden bij Google voor indexering. Een 404 is een pagina, waar verder geen content op staat.

Urgentie: Als u een URL heeft ingediend, die een 404 is, dan kan dat twee dingen betekenen: of u heeft de verkeerde URL gepakt of u heeft de juiste URL gepakt, maar de content staat er nog niet op. En dat is wel een probleem.

Oplossing: Heeft u de verkeerde URL gekozen, bied dan gewoon de juiste URL aan in Search Console. Heeft u wel de goede URL, zorg dan dat er content op die pagina komt te staan en bied de pagina opnieuw aan.

Betekenis: Als een URL is geïndexeerd, dan betekent dit dat hij op ’index’ staat. Als een artikel geblokkeerd is door de robots.txt, betekent dat hij op ‘disallow’ staat. De pagina kan dan wel geïndexeerd worden, maar de crawlers mogen er niet op komen. En dat is gek. Want u wilt dat een artikel toegestaan en geïndexeerd wordt, of u wilt, dat een pagina juist níet toegestaan en geïndexeerd wordt. En dat wordt nu door elkaar gehaald.

Urgentie: Dit is afhankelijk van de pagina waar het om gaat. Is het een belangrijke pagina, dan moet u hier direct wat aan doen. Is dit een of andere auteurspagina, dan heeft dit geen prioriteit.

Oplossing: Als het om een pagina gaat, die belangrijk voor u is, dan moet u de disallow uit de robots.txt halen. Wilt u, dat deze helemaal niet in Google staat? Dan hoeft u de pagina alleen nog maar op noindex te zetten.

Betekenis: De sitemap is de plattegrond van uw website. Met andere woorden: daar staat precies welke pagina waar staat. Als u deze melding ziet in Search Console, dan staat de desbetreffende pagina niet in uw plattegrond. Al wordt-ie wel meegenomen in de indexatie.

Urgentie: Dit is afhankelijk van wat u fout doet. Is het goed, dat de pagina niet in de sitemap staat? Dan wilt u de pagina zeer waarschijnlijk niet geïndexeerd hebben. Is het wel een belangrijke pagina en moet hij dus in uw sitemap? Dan is dit belangrijk.

Oplossing: Een onbelangrijke pagina wilt u in dit geval op noindex zetten. Een belangrijke pagina wilt u in de sitemap hebben. U kan de sitemap opnieuw genereren.

Betekenis: U weet inmiddels wat een omleiding is. Dat is namelijk een redirect. Wanneer Search Console de melding ‘pagina met omleiding’ geeft. Dit betekent dan dat Google de URL (ooit) ergens is tegengekomen en dat deze geredirect wordt.

Urgentie: Dit is in het overgrote deel van de gevallen niet erg. Als u een aantal pagina’s heeftt aangepast en geredirect, dan zal Google dit zien.

Oplossing: Stel, u had vroeger een blog op /actueel/, maar nu staat datzelfde blog op /blog/. Als u nog /actueel/ in uw menu heeft staan, dan is dat niet bevorderlijk voor uw interne linkbuilding. Probeer dus geredirecte links zo goed mogelijk bij de bron aan te pakken. Dit kan er ook voor zorgen, dat u minder van dit soort meldingen terugziet.

Betekenis: Dit is wellicht een van de lastigste dekkingsfouten als u naar de titel kijkt. Maar eigenlijk is het heel simpel. Dit betekent, dat de pagina een canonical heeft naar de juiste pagina.

Urgentie: Totaal niet. Dit is namelijk iets goeds. U hoeft hier niks aan te doen. Google rapporteert dit alleen wel, zodat het in het overzicht staat. U moet natuurlijk wel controleren of het klopt, maar in 9 van de 10 gevallen hoeft u hier niks mee te doen.

Oplossing: Die is er dus niet 😉

4.9 Gecrawld – momenteel niet geïndexeerd

Betekenis: Als een pagina niet geïndexeerd is, betekent dit, dat deze niet wordt meegenomen in de zoekresultaten van Google. Wanneer een pagina is gecrawld, betekent dit dat Google als het ware langs is geweest. Met andere woorden: de pagina heeft geen disallow.

Dit is dus eigenlijk het tegenovergestelde van de dekkingsfout ‘Geïndexeerd, maar geblokkeerd door robots.txt’.

Urgentie: Als een belangrijke pagina is gecrawld maar niet geïndexeerd, dan moet u dat direct oplossen. Is het geen belangrijke pagina? Dan heeft dit geen hoge prioriteit.

Oplossing: Als het een belangrijke pagina is, dan moet u ervoor zorgen, dat deze zo snel mogelijk wordt geïndexeerd. Bied ‘m direct aan bij Google en verwijder de noindex als deze erop staat.

Wilt u, dat deze pagina niet geïndexeerd wordt? Zorg er dan ook voor dat hij niet meer gecrawld kan worden middels een disallow in uw robots.txt.

4.10 Dubbele pagina, Google heeft een andere canonieke pagina gekozen dan de gebruiker

Betekenis: De canonical is de oplossing voor dubbele content. Maar in bepaalde gevallen kan Google de canonical negeren, omdat ze denkt dat ze het beter weet. En dat is het geval bij deze dekkingsfout.

U kan misschien pagina A als canonical hebben ingesteld, maar Google overrulet dat door pagina B te pakken.

Urgentie: Als Google het bij het rechte eind heeft, dan is dat natuurlijk geen probleem. Maar als Google het níet bij het juiste eind heeft, dan is dit wél een probleem. Dan moet u er meteen aan werken.

Oplossing: De oplossing hier is niet ‘doe dit en u lost het op’. Het is heel belangrijk om uw canonicals goed te controleren en waar nodig aan te passen. Verder moet u dubbele content zo goed mogelijk vermijden en ook de noindex, disallow, etc. goed controleren en aanpassen.

4.11 Uitgesloten door tag noindex

Betekenis: Als een pagina de noindex tag heeft, dan wordt hij niet geïndexeerd door Google. Oftewel: Google neemt ‘m niet mee in de indexatie.

Urgentie: In het gros van de gevallen heeft een pagina een noindex, omdat u niet wilt, dat deze geïndexeerd wordt. Dan hoeft u er dus niks aan te doen.

Oplossing: De pagina op index zetten, als u wel wil, dat hij in Google te vinden is.

4.12 Dubbele pagina zonder door de gebruiker geselecteerde canonieke versie

Betekenis: Dit is eigenlijk bijna hetzelfde probleem als bij ‘Dubbele pagina, Google heeft een andere canonieke pagina gekozen dan de gebruiker’, alleen hier heeft de pagina geen canonical. Oftewel: Google is lekker aan het freestylen.

Urgentie: Dit is wel iets wat u echt op moet pakken. U wilt namelijk niet, dat Google gaat freestylen en zelf gaat nadenken.

Oplossing: De oplossing is om te gaan werken met canonicals. Zorg, dat u dubbele content vermijdt. Kan het niet anders, werk dan met canonical. Zorg bij alles wat geen dubbele content heeft voor een ‘self-referencing’ canonical. Dat laatste is een canonical die naar zichzelf verwijst. Dat kan voorkomen dat Google gaat freestylen.

4.13 Ingediende URL gemarkeerd als noindex

Betekenis: U weet inmiddels wat een ingediende URL is: een URL die u heeft aangeboden in Search Console. Als deze pagina een noindex heeft en u biedt ‘m aan, dan krijgt u deze melding.

Urgentie: Extreem hoog als u wilt dat de URL in Google te vinden is ;-).

Oplossing: De noindex van de pagina afhalen en de pagina opnieuw aanbieden.

4.14 Niet gevonden (404)

Betekenis: Als een URL op een 404-pagina uitkomt, dan betekent, dat er op die pagina geen content staat. Die kan verwijderd zijn, verkeerd zijn geredirect of überhaupt nooit hebben bestaan.

Urgentie: 404’s wilt u eigenlijk altijd vermijden. Google zegt zelf, dat een 404 niet erg is als u zeker weet, dat de URL nooit heeft bestaan. Maar ik zou 404’s altijd oppakken. Ze hebben niet de hoogste prioriteit, maar u mag ze zeker niet vergeten.

Oplossing: De URL redirecten naar de vervangende pagina, de pagina die er het meest op lijkt of anders naar de homepage.

4.15 Soft 404

Betekenis: Een soft 404 is een 404, maar dan softer ;-). Nee, dat is een beetje flauw. Een soft 404 is minder ‘hard’ dan een normale 404. Bij een 404 is het echt een dood eind en bij een soft 404 kan het zijn dat de server niet meegeeft dat er iets goed gaat. Het kan ook zo zijn dat de pagina wel bestaat, maar geen of nagenoeg geen content heeft. Dan kan Google ook het label soft 404 erop knallen.

Urgentie: Dezelfde urgentie als de reguliere 404’s.

Oplossing: De lege pagina eventueel verwijderen en redirecten. Of een redirect toevoegen als de pagina niet bestaat.

Bij het opzetten van uw website of blog moet u uw voorkeursdomein specificeren. Hiermee instrueer u zoekmachines welke variant van het domein u wilt gebruiken gedurende de levensduur van uw website. Laten we eens kijken waarom u dit moet doen. Een website is standaard toegankelijk met www en zonder www voor een domeinnaam. Als uw domein bijvoorbeeld voorbeeld.com is, is uw website toegankelijk via zowel http://www.voorbeeld.com als http://voorbeeld.com (dus zonder www). Hoewel dit oké is voor gebruikers, is het verwarrend voor zoekmachines omdat ze deze als twee verschillende websites beschouwen. Dit betekent, dat u indexeringsproblemen, dubbele content problemen en verlies van paginarangschikking kunt tegenkomen. Om dit probleem op te lossen, moet u uw voorkeursdomein instellen en zoekmachines informeren over uw keuze.

Een van de vragen, die veel mensen hebben, is of ze www voor hun domein moeten gebruiken of dat ze voor de niet-www-versie moeten gaan. Er is geen SEO – voordeel om het ene formaat boven het andere te kiezen. Het is een kwestie van persoonlijke voorkeur. Het is belangrijk om zoekmachines te informeren over uw beslissing en consistent te zijn gedurende de hele levensduur van uw website.

Hoe u uw voorkeursdomein instelt

In het verleden was de instelling om uw voorkeursdomein op te geven beschikbaar in Google Search Console, maar Google besloot deze optie te verwijderen en te vertrouwen op canonieke URL’s.

Als u klaar bent met het instellen van uw voorkeursdomein, is de volgende stap het controleren en optimaliseren van uw robots.txt-bestand.

Robots.txt is een tekstbestand, dat zich in de hoofdmap van uw website bevindt. Het geeft instructies aan zoekmachines over welke pagina’s van uw website ze kunnen crawlen en aan hun index kunnen toevoegen. Het formaat van dit bestand is heel eenvoudig en in de meeste gevallen hoeft u er geen wijzigingen in aan te brengen.

Een ondiepe, logische sitestructuur is belangrijk voor gebruikers en zoekmachinebots. Bovendien helpt een interne linkstructuur om de rangschikkingskracht (zogenaamde link juice) efficiënter over uw pagina’s te verspreiden. Terwijl u uw interne links controleert, controleert u de klikdiepte. Zorg ervoor, dat de belangrijke pagina’s van uw site niet meer dan drie klikken verwijderd zijn van de startpagina. Paginering van blogpagina’s is noodzakelijk voor vindbaarheid door zoekmachines, maar vergroot de klikdiepte. Gebruik een eenvoudige structuur in combinatie met een krachtige zoekfunctie op de site om het voor gebruikers gemakkelijker te maken om elke bron te vinden.

Stop in de URL’s van uw webpagina’s en blogs geen tekens, liggende streepjes, onnodige cijfers of andere gekke dingen. Het is belangrijk om URL’s zo schoon mogelijk te houden. Maak URL’s zo kort mogelijk.

Zorg vervolgens, dat er een relevant zoekwoord in de URL staat. De URL moet er dus mooi en duidelijk uitzien.

Het crawlbudget is het aantal pagina’s, dat zoekmachines gedurende een bepaalde periode crawlen. Het crawlbudget is op zichzelf geen ranking factor. Het bepaalt echter wel, hoe vaak de pagina’s van uw site worden gecrawld (en of sommigen ervan überhaupt worden gecrawld). Afhankelijk van hoe belangrijk uw website is, geeft Google u een bepaald crawlbudget. Als uw pagina’s licht zijn en uw bronnen gemakkelijk toegankelijk zijn, zal dit budget een lange weg gaan. Maar als er te veel omleidingen en doodlopende wegen zijn, is uw budget al uitgegeven voordat het zelfs maar op belangrijke pagina’s komt.

Het is gebruikelijk om gifs, memes en video’s te gebruiken om uw pagina’s op te fleuren. Deze bronnen zijn bedoeld om uw gebruikers te entertainen, maar ze doen er eigenlijk niet toe voor zoekmachines. Het goede nieuws is, dat u Google kunt vragen deze bronnen te negeren en iets anders te gaan crawlen. Om dat te doen, bewerkt u uw robots.txt-bestand om afzonderlijke bronnen niet toe te staan:

User-agent: * Niet

toestaan: /images/filename.jpg

Of zelfs bepaalde bestandstypen:

User-agent: *

Niet toestaan: /*.gif$

Wanneer er te veel omleidingen (redirects) zijn, stopt Google meestal met het volgen van het spoor en gaat naar andere delen van uw website. Wat betekent dat sommige van uw pagina’s misschien nooit het daglicht zullen zien. Dat komt bovenop het verspillen van een stel kruipende eenheden voor niets. Als u dergelijke pagina’s vindt, corrigeer dan de omleidingen om rechtstreeks naar de landingspagina te gaan.

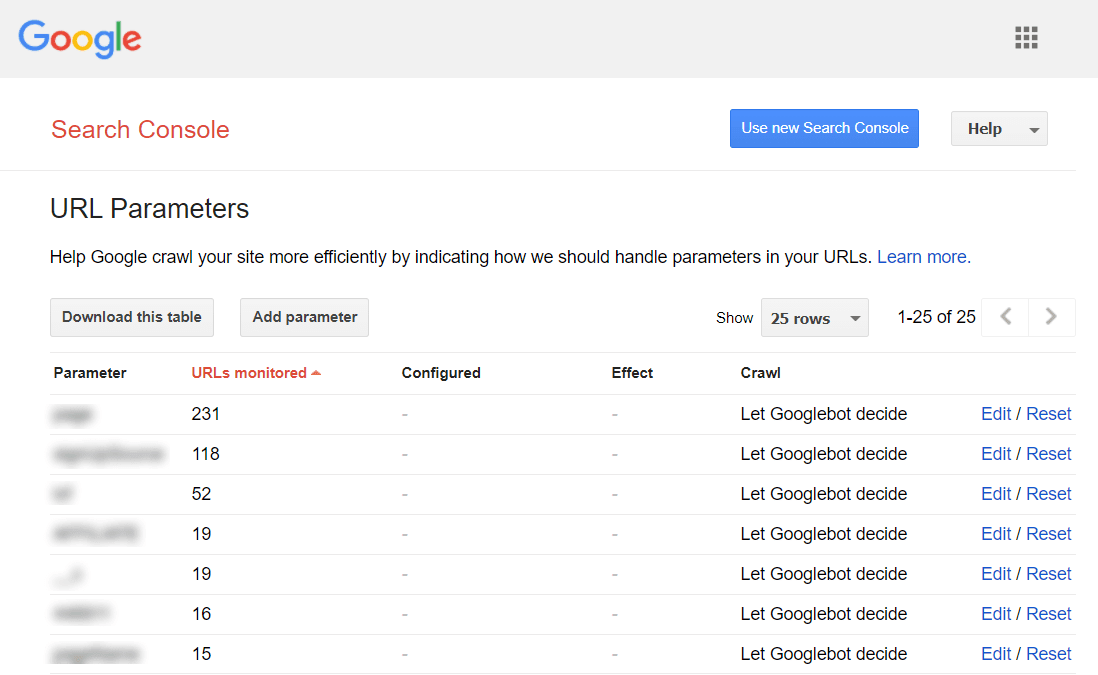

Het is gebruikelijk, dat content management systemen een heleboel dynamische URL’s genereren. In principe kan elk van uw pagina’s een paar verschillende URL’s hebben, afhankelijk van hoe u daar bent gekomen of het type filters, dat u heeft gebruikt. Google kan elk van deze URL’s als een andere pagina zien, ook al is de content grotendeels hetzelfde. Om te voorkomen, dat Google een aantal bijna identieke pagina’s crawlt, kunt u Google vragen bepaalde URL-parameters te negeren. Om dat te doen, start u Google Search Console en gaat u naar Verouderde tools en rapporten > URL-parameters :

Klik aan de rechterkant op Bewerken en vertel Google welke parameters moeten worden genegeerd.

Wanneer een zoekbot een 4XX/5XX-pagina bereikt, gaat een deel van uw crawlbudget verloren. Daarom is het belangrijk om alle verbroken links op uw site te vinden en op te lossen. ‘Broken links’ verspillen niet alleen uw crawlbudget, maar brengen ook bezoekers in verwarring en verslinden ‘link juice’.

Duplicated content is geen groot probleem voor SEO, maar het kan een beetje rommelig worden. Als er twee of meer bijna identieke pagina’s op uw website zijn, welke moet dan worden geïndexeerd? Wat als Google besluit, dat uw duplicated content een teken van plagiaat of spam zijn? Het is het beste om het niet te riskeren. Als u duplicated content vindt, kunt u deze ofwel helemaal verwijderen of verbergen voor zoekmachines.

Google verwacht, dat pagina’s binnen twee seconden of minder worden geladen. Ondertussen is de gemiddelde pagespeed op internet ongeveer 15 seconden. De kans is dus groot, dat u ook uw SEO pagespeed moet verbeteren. Paginasnelheid is echter niet eenvoudig te meten en Google worstelt al heel lang met deze statistiek. Eindelijk is het aangekomen bij het ‘Core Web Vitals’. Dit zijn drie statistieken, die zijn ontworpen om de waargenomen snelheid van een bepaalde pagina te meten. De statistieken zijn Largest Contentful Pain (LCP), First Input Delay (FID) en Cumulatieve Layout Shift (CLS).

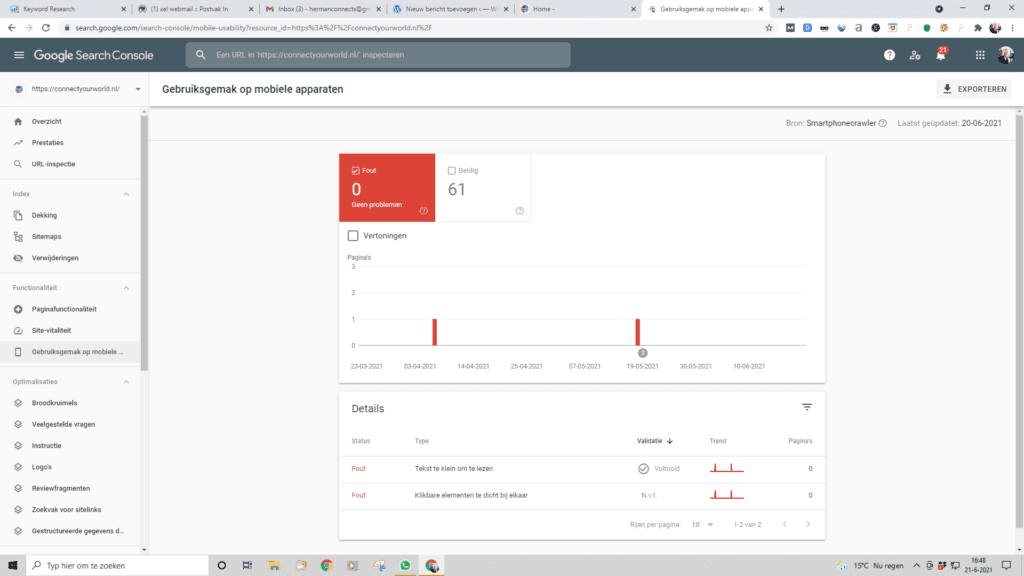

In 2018, na anderhalf jaar van zorgvuldig experimenteren en testen, begon Google met het migreren van sites naar mobile-first indexing. De algoritmen stellen zoekmachines in om de mobiele versies van websites te crawlen in plaats van hun desktopversies. En dit betekent letterlijk dat de mobiele versie van uw pagina’s bepaalt, hoe ze scoren in zowel mobiele als desktop-zoekresultaten. De mobielvriendelijke test van Google omvat een selectie van bruikbaarheidscriteria, zoals viewportconfiguratie, gebruik van plug-ins en de grootte van tekst en klikbare elementen. Het is ook belangrijk om te onthouden, dat mobielvriendelijkheid wordt beoordeeld op paginabasis, dus u moet elk van uw landingspagina’s afzonderlijk en één voor één controleren op mobielvriendelijkheid. Om u hele website te beoordelen kun je beter overstappen op Google Search Console. Daar, onder het tabblad ‘Ervaring’, vindt u het rapport Mobiel bruikbaarheid voor al uw pagina’s:

Onder de grafiek staat een tabel met de meest voorkomende problemen, die van invloed zijn op uw mobiele pagina’s. U kunt verder onderzoek doen door op één van de problemen te klikken.

Google is in 2014 begonnen met het gebruik van HTTPS als ranking-signaal . Sindsdien komen HTTPS-migraties steeds vaker voor. Volgens het Google Transparantie Rapport gebruikt 95% van de websites op Google tegenwoordig HTTPS. Als uw site nog niet over HTTPS beschikt, kunt u een HTTPS-migratie overwegen. Als uw website al gebruik maakt van HTTPS (gedeeltelijk of volledig), is het belangrijk om de veelvoorkomende HTTPS-problemen te controleren als onderdeel van uw SEO Audit. Vergeet vooral niet te controleren op:

Problemen met gemengde inhoud ontstaan wanneer een anders beveiligde pagina een deel van de content (afbeeldingen, video’s, scripts, CSS-bestanden) laadt via een niet-beveiligde HTTP-verbinding. Dit verzwakt de beveiliging van de pagina en kan voorkomen dat browsers de niet-beveiligde inhoud of zelfs de hele pagina laden.

Eerst moet u controleren op dubbele HTTP- versus HTTPS-versies van uw pagina’s, in het gedeelte Site-audit > Omleidingen . Als de HTTP- en HTTPS-versies van uw website niet correct zijn ingesteld, kunnen ze allebei tegelijkertijd worden geïndexeerd door zoekmachines. Dit veroorzaakt dubbele inhoudsproblemen die uw website rankings kunnen schaden. In het ideale geval zouden alle links op uw HTTPS-site, evenals omleidingen en canonicals, meteen naar HTTPS-pagina’s moeten verwijzen. Zorg ervoor, dat u de juiste omleiding van HTTP naar HTTPS instelt, merk problemen op met www en niet-www-versies van uw site. Ten tweede, zelfs als u de HTTP-naar-HTTPS-omleidingen correct op de hele site hebt geïmplementeerd, wilt u gebruikers niet door onnodige omleidingen leiden. Hierdoor zal uw website veel langzamer lijken dan hij is. Dergelijke omleidingen kunnen ook een probleem zijn voor het crawlen, omdat u een beetje van uw crawlbudget verspilt telkens wanneer een bot van een zoekmachine een omleiding bereikt.

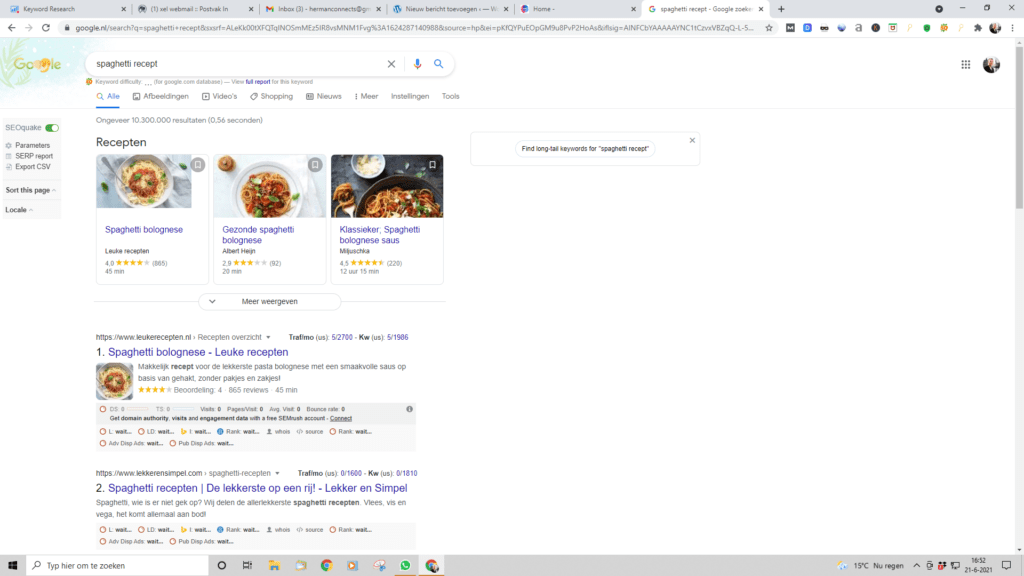

Gestructureerde gegevens zijn in wezen HTML-code, die wordt gebruikt om specifieke elementen op uw pagina te taggen. Als uw pagina bijvoorbeeld een recept voor Spaghetti is, kunt u Google vertellen welke tekst de ingrediënten zijn, wat de kooktijd, het aantal calorieën, enzovoort is. Google kan de tags vervolgens gebruiken om rich snippets voor uw pagina’s in de SERP te maken:

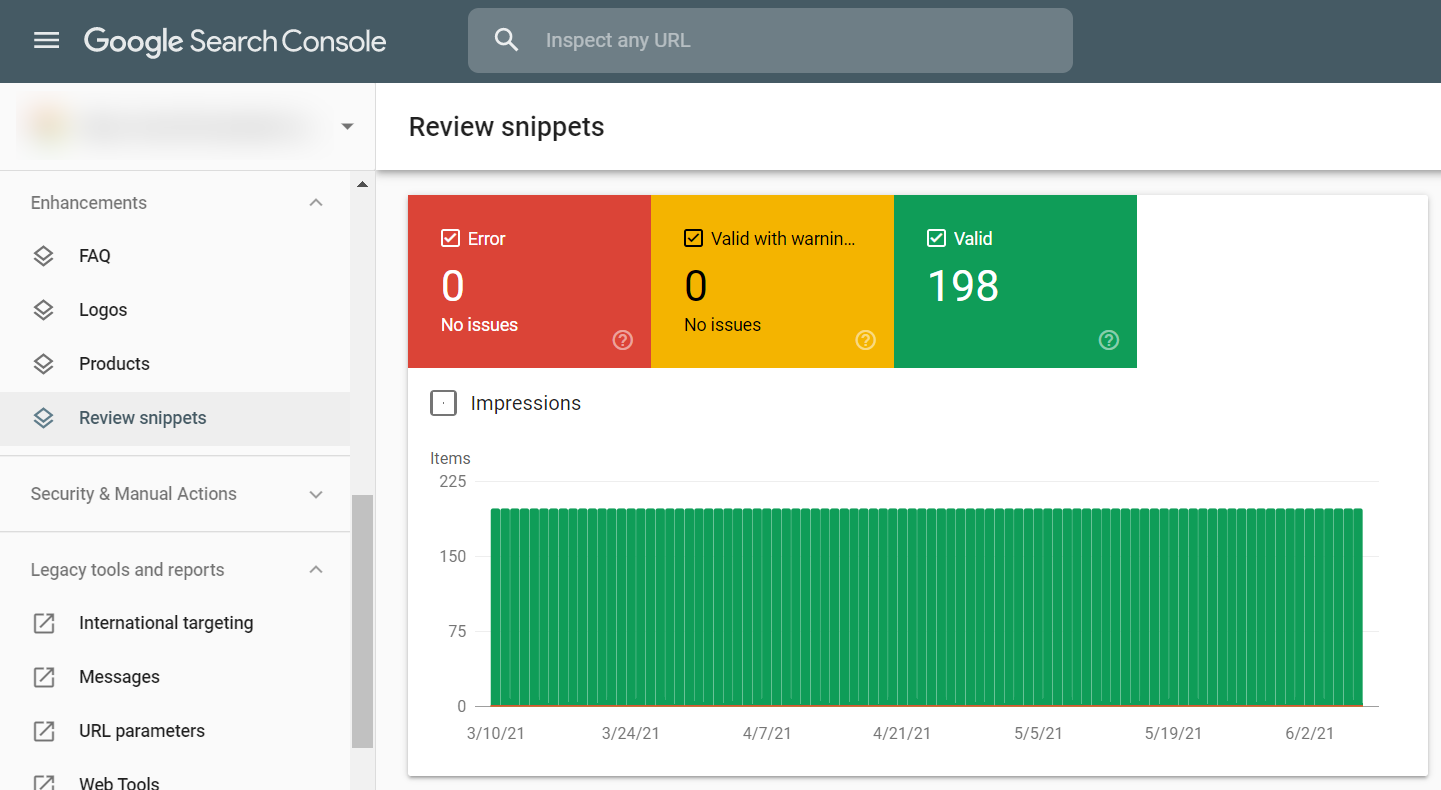

U kunt uw gestructureerde gegevens controleren in de Google Search Console onder het tabblad Verbeteringen. Google geeft de verbeteringen weer die u op uw website heeft geprobeerd te implementeren en laat u weten of dit is gelukt:

Als uw website een CMS gebruikt, kunnen gestructureerde gegevens standaard worden geïmplementeerd of u kunt dit implementeren door een plug-in te installeren. Als u een op maat gemaakte website heeft, kunt u een hulptool gebruiken om uw pagina’s te taggen.

Wat is het voordeel van het gebruik van gestructureerde data ?

Het kan u helpen de presentatie van uw vermeldingen in de SERPS te verbeteren, hetzij via aanbevolen fragmenten , kennisgrafieken, enz., en uw CTR te verhogen.

Wat zijn de toepassingen van gestructureerde gegevens?

Er zijn veel manieren waarop u gestructureerde gegevens kunt gebruiken om uw content te beschrijven. De meest populaire zijn: artikelen, recepten, evenementen, vacatures, lokale bedrijven en meer. U kunt de volledige lijst hier bekijken .

Een XML-sitemap is een bestand dat de URL’s van uw site weergeeft en waarmee u informatie over elke pagina van uw site kunt verstrekken om de crawlers van zoekmachines te helpen deze beter te navigeren en te indexeren.

Vaker wel dan niet, bevindt uw XML-sitemap zich in de hoofdmap van uw domein, dus het is meestal vrij eenvoudig te vinden. Er zijn een aantal manieren waarop u de XML-sitemap op uw site kunt vinden – of zelfs om te ontdekken of u er een heeft. Gebruik veelvoorkomende formaten om te lokaliseren. Er zijn enkele standaard naamgevingsconventies, dus probeer die eerst. Begin met deze: URL + sitemap.xml of sitemap_index.xml of sitemap1.xml.

In een wereld waar Google koning is, is het essentieel om uw site fris en bijgewerkt te houden met nieuwe content. Hierbij zijn XML-sitemaps essentieel voor SEO omdat ze zoekmachines zoals Google in staat stellen om alle pagina’s op uw website te vinden, die ze anders misschien niet zouden hebben gevonden. Dit kan betekenen, dat er meer organisch verkeer binnenkomt en meer geld voor uw bedrijf! XML-sitemaps helpen Google uw site te crawlen en snel naar nieuwe inhoud te gaan. Zie de XML-sitemap als een stappenplan. Langs komt Google, en het komt op een pagina op uw website. Laten we, omwille van het argument, zeggen dat dit de startpagina is. Van daaruit crawlt het je navigatie en begint het die pagina’s te ontdekken, en gaat dan op jacht om andere pagina’s te vinden.

Google heeft in het verleden gezegd dat kleine sites niet echt een XML-sitemap nodig hebben (zie onderstaande quote van John Mueller) en dat ze nuttiger zijn voor grotere sites. Ik zou zeggen dat het niet uitmaakt hoe groot of klein je site is – u zou nog steeds een XML-sitemap moeten hebben. Ze zijn zo gemakkelijk te maken (met behulp van een plug-in zoals Yoast of een tool zoals Sitebulb of Screaming Frog), dat u gek zou zijn om dat niet te doen. Een taak die een paar minuten duurt voor een eenvoudige site, helpt Google de gewenste URL’s te vinden.

“Met een site van die grootte heb je niet echt een sitemapbestand nodig, we kunnen over het algemeen toch alles crawlen en indexeren.

John Mueller – Google Webmaster Forum

Met zo’n klein sitemapbestand kun je ook gewoon de afzonderlijke URL’s controleren om te zien of ze op die manier zijn geïndexeerd.’

Uw sitemap vertelt zoekmachines over uw sitestructuur en laat ze nieuwe content ontdekken. Als u geen sitemap heeft, moet u er nu echt een gaan maken. Als u uw sitemap controleert, zorg er dan voor dat deze:

Schoon. Houd uw sitemap vrij van fouten, omleidingen en URL’s die worden geblokkeerd voor indexering; anders loopt u het risico dat zoekmachines de sitemap negeren alsof deze er niet is.

Actueel. Zorg ervoor, dat uw sitemap wordt bijgewerkt, telkens wanneer nieuwe content aan uw website wordt toegevoegd of ervan wordt verwijderd. Dit zal zoekmachines zoals Google helpen nieuwe content snel te ontdekken.

Beknopt. Google crawlt geen sitemaps van meer dan 50.000 URL’s. Idealiter zou u het veel korter moeten houden om ervoor te zorgen dat uw belangrijkste pagina’s vaker worden gecrawld: technische SEO experimenten tonen aan dat kortere sitemaps resulteren in effectievere crawls .

Geregistreerd in Search Console. Laat Google weten, wat uw sitemap is. U kunt het handmatig indienen bij Google Search Console of de locatie op de volgende manier ergens in uw robots.txt-bestand opgeven:

Sitemap: http://uwdomein.com/sitemaplocatie.xml

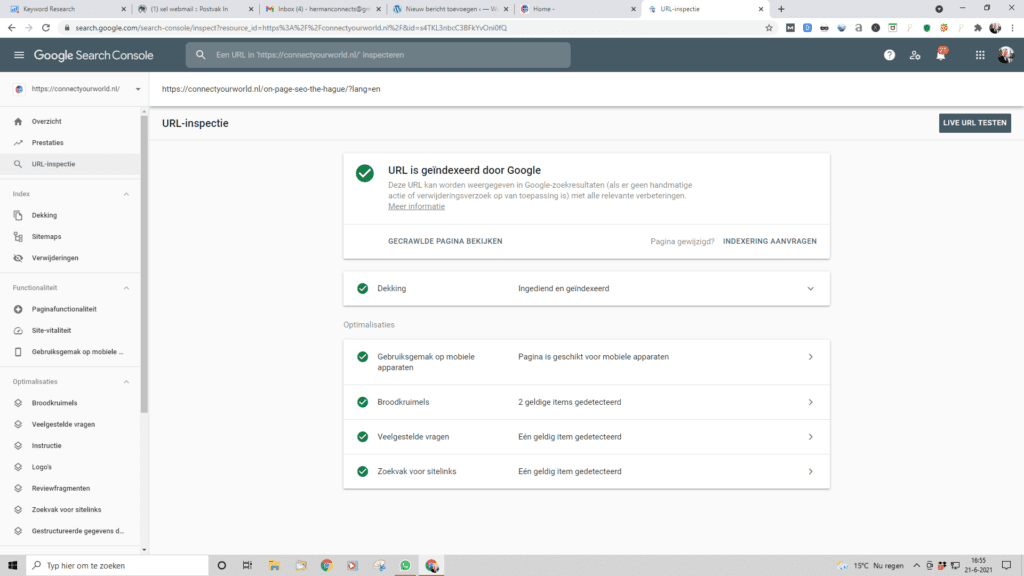

De bovenstaande SEO site-audit zal zeker een paar technische SEO problemen op uw site onder de aandacht brengen, die moeten worden opgelost. Zodra u ze heeft opgelost, kunt u Google expliciet vragen uw pagina’s opnieuw te crawlen, om ervoor te zorgen, dat de wijzigingen zo snel mogelijk worden doorgevoerd. U kunt uw bijgewerkte URL’s voor opnieuw crawlen verzenden vanuit Google Search Console met behulp van de URL-inspectietool. Voer de URL in van de pagina die u opnieuw wilt crawlen en klik op ‘Indexering aanvragen’. U kunt ook de Live URL testen (voorheen bekend als de functie Fetchen als Google) om uw pagina in zijn huidige vorm te zien en vervolgens indexering aanvragen.

Met de URL-inspectietool kunt u het rapport uitbreiden voor meer details, de live-URL testen en indexering aanvragen.

U moet beoordelen wanneer u echt opnieuw moet crawlen. Bijvoorbeeld na het doorvoeren van serieuze wijzigingen op de site: u heeft uw site van http naar https verplaatst, gestructureerde gegevens ingevoerd of essentiële content optimalisatie uitgevoerd. Of u wilt, dat een dringende blogpost sneller op Google verschijnt. Er wordt aangenomen dat er een limiet is voor het aantal herhalingsacties per maand, dus maak er geen misbruik van. Het opnieuw crawlen kan 10 minuten tot enkele weken duren. Een beter alternatief voor opnieuw crawlen is om enorme wijzigingen door te geven via de sitemap. Google kan niet garanderen, dat alle pagina’s van uw website worden geïndexeerd, maar als de site vrij klein is, zal dit hoogstwaarschijnlijk wel gebeuren.

Er is ook een vergelijkbare optie in Bing Webmaster Tools. Zoek gewoon het gedeelte Mijn site configureren in uw dashboard en klik op URL’s indienen. Vul de URL in, die u opnieuw wilt laten indexeren, en Bing zal deze doorgaans binnen enkele minuten crawlen. Met de tool kunnen webmasters voor de meeste sites tot 10.000 URL’s per dag indienen.

Core Web Vitals zijn de nieuwe standaarden van Google om te evalueren of een pagina een goede gebruikerservaring biedt.

De Core Web Vitals bestaan uit:

Als het gaat om het testen van uw site om te zien hoe goed deze voldoet aan de Core Web Vitals-benchmarks, is het belangrijk dat aan alle drie de statistieken wordt voldaan, zegt John Mueller.

Tenslotte. Een regelmatige site-audit moet een prioriteit zijn in uw SEO-strategie. Welke veranderingen er ook op internet verschijnen, ze kunnen de ranglijst op een zeer onvoorspelbare manier beïnvloeden. Daarom is het echt verstandig om SEO analyse tools in te stellen voor regelmatige technische SEO controles om SEO optimalisatie problemen te detecteren en op te lossen zodra ze zich voordoen.

Een broodkruimelmenu is een reeks links boven of onder aan een pagina, waarmee gebruikers naar een vorige pagina (meestal de categoriepagina) of naar de startpagina van een website kunnen navigeren. Een broodkruimelmenu heeft twee hoofddoelen: het helpt gebruikers gemakkelijk door een website te navigeren zonder op de terugknop van hun browser te hoeven drukken. Het geeft zoekmachines nog een hint over de structuur van een website. ,Breadcrumbs worden in verschillende SEO Guides als SEO-element genoemd omdat ze sterk worden aanbevolen door Google. Als u breadcrumbs nog niet hebt ingeschakeld, zorg er dan voor dat ze zijn ingeschakeld op uw website en dat ze het juiste schema hebben.

Deze technische SEO checklist heeft als doel om met u te delen, wat er allemaal op het gebied van SEO techniek moet gebeuren om van uw website een goed scorende site te maken. Technische SEO kan lastig zijn en heeft vele valkuilen. Een SEO specialist inhuren is daarom altijd een verstandige keuze. De SEO expert begeleidt u graag naar de posities bovenaan in Google met uw website.

Herman Geertsema is de eigenaar en freelance SEO specialist van SEO en Content Marketing bureau Connect your World gevestigd in Den Haag. Hij is een ervaren SEO consultant en Content Marketeer. Connect your World voert online marketing projecten uit op het gebied van zoekmachineoptimalisatie, Linkbuilding, Contentmarketing, Sociale Media en Google Ads. Hij heeft ook kennis van de SEO techniek.

Kies ook een SEO specialist voor een goede SEO analyse in de volgende regio’s:

Heeft u een vraag over technische SEO, Google Ads Campagnes of iets anders? Of wilt u ons als SEO tekstschrijver of SEO specialist inhuren om bovenaan in Google te komen? Neem dan contact op via onderstaande button.

Wilt u zelf een SEO check uitvoeren voor uw website? Maak dan gebruik van de vele SEO checklists op deze website of ons overzicht met veelal gratis SEO tools.