Last Updated on 12 december 2025 by connectyourworld

Google Search Console is één van de gratis webmaster tools van Google. Deze SEO tool is onmisbaar voor de webmaster of SEO specialist. Met behulp van Google Search Console kunt u de XML sitemap van uw website indienen. Daarmee regelt u, dat uw website in de Google index komt te staan en zo geïndexeerd wordt.

Daarnaast kunt u Search Console weer gebruiken om eventueel een verouderde niet meer relevante content te verwijderen of om diverse andere fouten te herstellen. Tevens biedt het een overzicht van statistieken met betrekking tot zoekprestaties en gebruikerservaringen om websites te verbeteren en meer verkeer te genereren. Met Search Console biedt Google ook een manier om te communiceren, wanneer het beveiligingsproblemen ontdekt. Het ‘zoekkwaliteitsteam’ kan ook een handmatige actiestraf opleggen. Daar van komt dan een vermelding in Google Search Console.

Estimated reading time: 34 minuten

Google Search Console is een verzameling tools, waarmee website eigenaren, webmarketeers en SEO specialisten de prestaties van websites in de zoekindex van Google kunnen volgen. Functies omvatten informatie over zoekopmaak, zoekverkeer, technische statusupdates, crawlgegevens en aanvullende educatieve bronnen.

Google Search Console is essentieel voor SEO optimalisatie, omdat het gedetailleerde inzichten biedt in hoe je website presteert in de zoekresultaten van Google. Het helpt bij het identificeren en oplossen van technische problemen, zoals crawl- en indexeerfouten, die de zichtbaarheid van uw site kunnen belemmeren. Met Search Console kunt u zoekverkeer en zoekwoorden analyseren om te begrijpen, welke content goed presteert en welke verbeterd moet worden. Het biedt ook meldingen voor beveiligingsproblemen, zoals malware, zodat u snel kunt reageren om de veiligheid van uw site te waarborgen. Daarnaast kunt u via de tool sitemaps indienen en controleren of nieuwe pagina’s correct geïndexeerd zijn. Ten slotte helpt het bij het monitoren van backlinks en het beoordelen van de kwaliteit van inkomende links, wat cruciaal is voor uw SEO strategie.

Google Search Console is één van de gratis en vreemde SEO tools. Het voelt als een ietwat willekeurige samenstelling van zoekrapporten. Sommige zijn nuttig, andere kunnen handig zijn als u weet wat u doet. Andere rapporten zijn gewoon mooi om naar te kijken, maar bieden geen echte inzichten. Positief is, dat Search Console betrouwbare gegevens rechtstreeks van Google haalt en deze gegevens zijn gratis te gebruiken voor alle website eigenaren. In deze blog bespreken we de handigere Google Search Console functies en geven wij gedetailleerde instructies over, hoe u ze in uw voordeel kunt gebruiken.

Ten eerste, aanmelden bij de Google Search Console en klik op “Object toevoegen”. Kopieer en plak vervolgens uw homepage-URL in het veld “Domein”. Vervolgens is het tijd om uw site te verifiëren.

Er zijn 7 manieren om uw site te verifiëren. Hier zijn de drie gemakkelijkste manieren om uw site te laten verifiëren:

Google doet behoorlijk goed werk om uit te zoeken op welk land uw site zich richt. Om dat te doen, kijken ze naar gegevens als:

Dat gezegd hebbende, hoe meer informatie u Google kunt geven, hoe beter.

Open uw Google Analytics . Klik vervolgens op de “Admin” -knop onderaan het linkermenu. Scrol omlaag totdat u de knop ‘Search Console aanpassen’ ziet. Klik er op!

Klik op “Toevoegen”.

Scroll naar beneden tot u uw website vindt, vink het vakje aan en klik op “Opslaan”. U bent klaar! Analytics en Search Console zijn nu gekoppeld.

Controleer ten slotte of u beveiligingsproblemen heeft die de SEO van uw site kunnen schaden. Om dat te doen, klikt u op “Beveiligingsproblemen”. En kijk wat Google zegt:

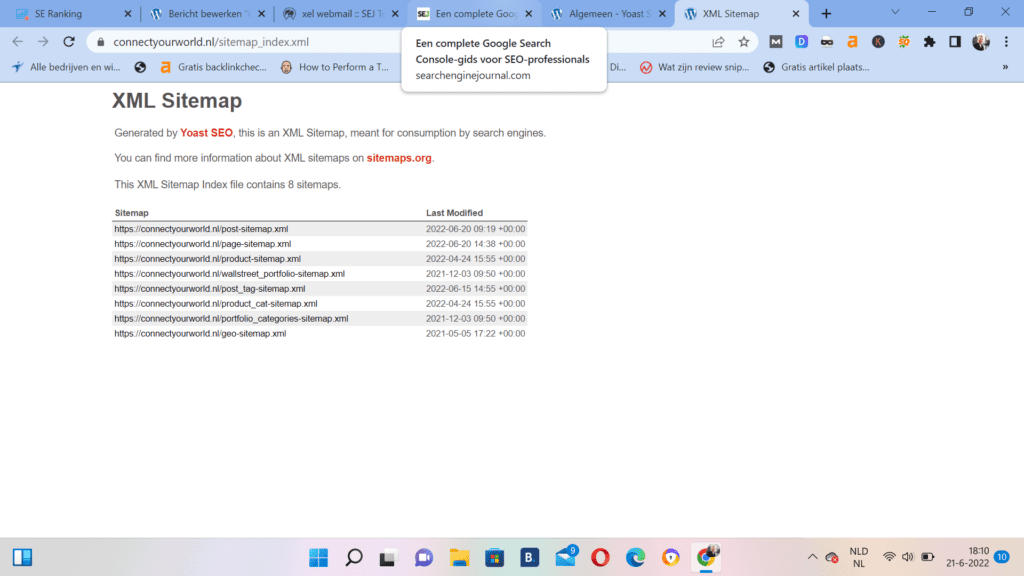

Als u een kleine site heeft, hoeft u waarschijnlijk geen sitemap naar Google te verzenden. Maar voor grotere sites, zoals e-commerce websites met duizenden pagina’s, is een sitemap de sleutel. Dat gezegd hebbende: ik raad u aan om op beide manieren een sitemap in te dienen. Hier is hoe het te doen: Allereerst moet u een sitemap maken.

Als u WordPress met de Yoast-plug-in gebruikt, zou u er al een moeten hebben. Als u nog geen sitemap hebt, ga dan naar Yoast. Stel vervolgens de instelling XML-sitemaps in op “Aan” (onder “Algemeen / Functies”): Gebruik Yoast niet? Ga naar uwsite.com/sitemap.xml. Als u een sitemap heeft, staat deze meestal hier. Zo niet, dan wilt u er een maken. Laten we dus een sitemap naar Google sturen. Grijp uw sitemap-URL. Klik vervolgens op de knop “Sitemaps”. Plak uw URL en klik op “Verzenden”.

Zoals u weet, zult u, wanneer u deze technische SEO optimalisatie problemen oplost, meestal hogere SEO rankings en meer verkeer krijgen. En de Google Search Console heeft veel functies waarmee u technische SEO problemen eenvoudig kunt opsporen en oplossen. Hier leest u hoe u ze kunt gebruiken.

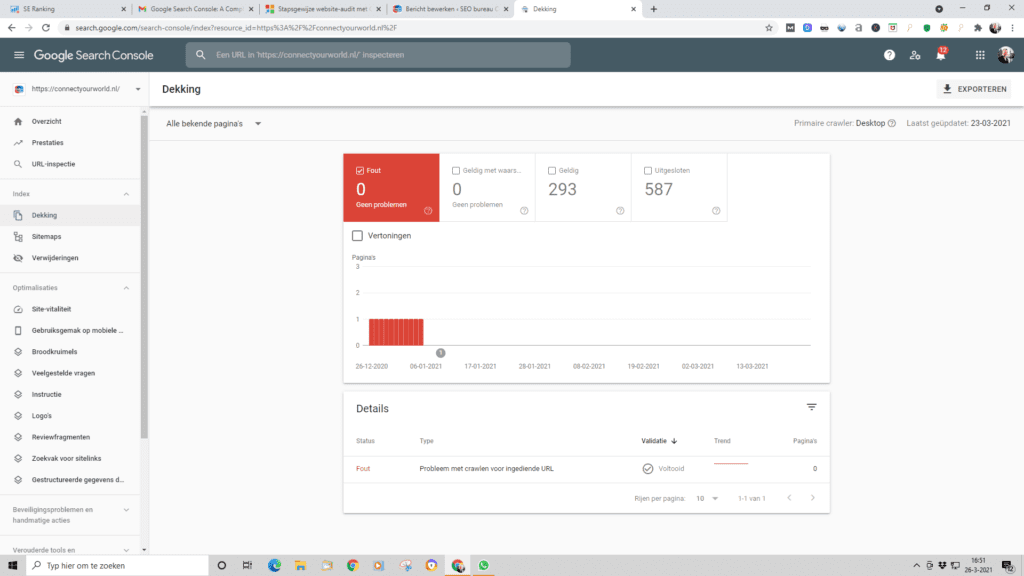

Het eerste, dat u moet controleren, is of Google toegang heeft tot alle pagina’s, die u in de zoekresultaten wilt weergeven. Er zijn veel redenen waarom Google geen toegang heeft tot 1 of meerdere van uw webpagina’s. Soms gebeurt dit per ongeluk. In dat geval heeft u een aantal van uw belangrijke pagina’s, die gewoon inactief blijven en geen verkeer genereren. Om te controleren of u indexeringsproblemen heeft, gaat u naar Index > Dekking en controleert u de status van de pagina’s van uw website:

Als alles op uw website correct is ingesteld, zal Google:

a) Uw pagina vinden

b) Deze snel toe voegen aan hun index

Maar soms gaat het mis en dat is waar het Index Coverage rapport om de hoek komt kijken.

Het rapport Indexdekking laat u weten, welke pagina’s van uw site in de index van Google staan. Het informeert u ook over technische problemen, die verhinderen, dat pagina’s worden geïndexeerd.

Het foutenrapport geeft alle gevallen weer, waarin het Google niet is gelukt uw pagina’s te indexeren omdat ze niet bestaan of toegangsbeperkingen hebben.

Bovenaan het rapport Indexdekking staan 4 tabbladen:

Laten we ons concentreren op het tabblad “fout”. Zoals u kunt zien, bevat deze site 54 fouten. De grafiek laat zien, hoe dat aantal in de loop van de tijd is veranderd. Als u naar beneden scrolt, krijgt u details voor elk van deze fouten.

Hier zijn de meest voorkomende indexeringsfouten en enkele tips om ze op te lossen:

Dit soort problemen doet zich voor wanneer u Google heeft gevraagd een URL te indexeren, maar de pagina is niet toegankelijk. Het eerste dat u hier moet controleren, is of u echt van plan was om de pagina in zoekresultaten weer te geven of niet. Als u niet wilt, dat uw pagina wordt geïndexeerd, moet u uw indexverzoek intrekken, zodat Google kan stoppen met proberen.

Dien hiervoor de URL ter inspectie in en kijk waarom Google deze in de eerste plaats probeert te indexeren. De meest waarschijnlijke reden is, dat u de URL per ongeluk aan een van uw sitemaps heeft toegevoegd. In dat geval kunt u de sitemap bewerken en de URL verwijderen. Als u wilt dat uw webpagina wordt geïndexeerd, moet u stoppen met het blokkeren van de toegang. Nu zijn er zes verschillende manieren waarop u Google kunt blokkeren, dus hier is wat u in elk geval kunt doen:

Dit betekent dat de pagina “niet gevonden” is, maar een verkeerde statuscode in de header heeft afgeleverd.

Er is een omleiding voor deze pagina (301/302). Maar het werkt niet.

De pagina is niet gevonden en de server heeft de juiste HTTP-statuscode (404) geretourneerd.

Dit kunnen 100 verschillende dingen zijn. U moet de pagina bezoeken om te zien wat er aan de hand is.

Googlebot heeft geen toegang tot de server. Het is mogelijk gecrasht, er is een time-out opgetreden of er is een storing opgetreden toen Googlebot langskwam. En als u op een foutstatus klikt, krijgt u een lijst met pagina’s met dat specifieke probleem. 404-fouten moeten eenvoudig op te lossen zijn. Dus laten we daarmee beginnen. Klik op een URL in de lijst. Dit opent een zijpaneel met 4 opties: Plaats vervolgens uw URL in het URL – inspectieveld boven aan de pagina. En Googlebot haast zich naar uw webpagina. En ja hoor, deze pagina geeft me nog steeds een 404-status “Niet gevonden”.

Laat het zoals het is. Google zal de pagina uiteindelijk deindexeren. Dit is logisch als de pagina om een bepaalde reden niet beschikbaar is. Denk bijvoorbeeld aan de mogelijkheid, dat u dit product niet meer verkoopt. U kunt de 404-pagina omleiden naar een vergelijkbare productpagina, categoriepagina of blogpost.

Nu is het tijd om deze vervelende “Soft 404” fouten op te lossen. Bekijk nogmaals de URL’s met die fout. Bezoek vervolgens elke URL in uw browser. Eens kijken of Google toegang heeft tot de pagina OK. Nogmaals, we zullen de URL-inspectietool gebruiken. Deze keer klikken we op de knop “Test Live URL”. Dit stuurt Googlebot naar de pagina. Het geeft vervolgens de pagina ook weer, zodat u uw pagina kunt zien zoals Googlebot deze ziet. Het lijkt erop dat Google de pagina deze keer heeft gevonden.

Klik vervolgens op het tabblad ‘Meer informatie’ en controleer op paginabronnen, die Google niet correct kon laden. Soms is er een goede reden om bepaalde bronnen van Googlebot te blokkeren. Maar soms kunnen deze geblokkeerde bronnen leiden tot zachte 404-fouten. Zodra u zeker weet dat eventuele indexeringsfouten zijn opgelost, klikt u op de knop “Indexering aanvragen”: Dit vertelt Google namelijk om de pagina te indexeren. De volgende keer dat Googlebot langskomt, zou de pagina moeten worden geïndexeerd.

U kunt exact hetzelfde proces gebruiken dat ik zojuist heb gebruikt voor “Soft 404s” om eventuele fouten op te lossen:

Hier zijn een paar voorbeelden:

Kort gezegd! Met wat werk kunt u vrijwel elke fout herstellen die u tegenkomt in het dekkingsrapport.

Ik weet niets over jou …

… Maar ik laat niets aan het toeval over als het om SEO gaat.

Wat betekent, dat ik niet rotzooi als ik een feloranje “Waarschuwing” zie. Laten we daarom naar het tabblad “Geldig met waarschuwingen” gaan in het Indexdekkingsrapport. Deze keer is er slechts één waarschuwing: “Geïndexeerd, maar geblokkeerd door robots.txt”. Dus wat is hier aan de hand? Laten we het uitzoeken. Het GSC laat ons weten dat de pagina wordt geblokkeerd door robots.txt. Dus in plaats van op “Fetch As Google” te klikken, klikt u op “Test Robots.txt Blocking”:

Dit brengt ons naar de robots.txt tester in de oude Search Console. Het blijkt dat deze URL wordt geblokkeerd door robots.txt. Dus wat is de oplossing? Welnu, als u wilt dat de pagina wordt geïndexeerd, moet u deze deblokkeren via Robots.txt. Maar als u niet wilt dat het wordt geïndexeerd, heeft u twee opties:

De URL Removal Tool is een snelle en gemakkelijke manier om pagina’s uit de index van Google te verwijderen. Helaas is deze tool nog niet overgeschakeld naar de nieuwe Google Search Console. U moet dus de oude GSC gebruiken om het te gebruiken. Vouw daarom het tabblad “Oude tools en rapporten” in de nieuwe GSC-zijbalk uit en klik vervolgens op “Verwijderingen”, waar u naar het oude GSC wordt geleid. Plak ten slotte de URL die u wilt verwijderen: Verdubbel triple check dat u de juiste URL heeft opgegeven en klik op “Submit Request”. Een verwijdering is namelijk slechts 90 dagen actief. Daarna zal Googlebot proberen de pagina opnieuw in de cache op te slaan. Maar aangezien de pagina wordt geblokkeerd via robots.txt. gaat deze pagina voorgoed weg,

Laten we nu verder gaan naar het tabblad “Geldig”. Dit vertelt ons namelijk hoeveel pagina’s er in Google worden geïndexeerd.

Ziet u een plotselinge daling van het aantal geïndexeerde pagina’s?

Dat kan een teken zijn, dat er bijvoorbeeld iets mis is:

Hoe dan ook, tenzij u met opzet een aantal pagina’s heeft gedeindexeerd, wilt u dit zeker eens bekijken. Aan de andere kant, wat als u een plotselinge toename van geïndexeerde pagina’s opmerkt? Nogmaals, dat kan een teken zijn dat er iets mis is. Misschien heeft u bijvoorbeeld een aantal pagina’s gedeblokkeerd, die zouden moeten worden geblokkeerd.

Ook dit is het waard om verder te onderzoeken.

Er zijn tal van goede redenen om te voorkomen, dat zoekmachines een pagina indexeren. Misschien is het een inlogpagina of misschien bevat de pagina duplicated content. Het kan ook zijn, dat de webpagina van lage kwaliteit is. Met lage kwaliteit bedoelen wij niet dat de pagina een zootje is. Het kan een nuttige pagina zijn voor gebruikers maar niet voor zoekmachines.

U wilt er zeker voor zorgen, dat Google geen pagina’s uitsluit die u wilt geïndexeerd. In dit geval hebben we veel uitgesloten pagina’s. En als u naar beneden scrolt, krijgt u een lijst met redenen waarom elke pagina is uitgesloten van de index van Google. Dus laten we dit maar opsplitsen …

De pagina verwijst door naar een andere URL. Dit is helemaal goed. Tenzij er backlinks (of interne links) naar die URL verwijzen, zullen ze uiteindelijk stoppen met proberen deze te indexeren.

Google heeft ergens anders een alternatieve versie van deze pagina gevonden. Dat is wat een canonieke URL zou moeten doen. Dus dat is oke.

Er kunnen een aantal dingen zijn. Dus we zullen het moeten onderzoeken. In dit geval lijkt het erop, dat de vermelde pagina’s een 404 retourneren.

Dit zijn pagina’s, die Google heeft gecrawld, maar om een of andere reden niet worden geïndexeerd. Google geeft u niet de exacte reden, waarom ze de pagina niet indexeren. Maar uit onze ervaring betekent deze fout: de pagina is niet goed genoeg om een plek in de zoekresultaten te verdienen.

Mijn advies: werk aan het verbeteren van de kwaliteit van alle vermelde pagina’s. Als het bijvoorbeeld een categoriepagina is, voegt u wat content toe die die categorie beschrijft. Als de pagina veel duplicated content bevat, maak deze dan uniek. Als de pagina niet veel content bevat, versterk het dan. Kortom, maak de pagina waardig voor de index van Google.

Dit zegt Google u: “Deze pagina heeft dezelfde content als een heleboel andere pagina’s. Maar we denken dat een andere URL beter is ” Ze hebben deze pagina dus uitgesloten van de index. Mijn advies: als u duplicated content op een aantal pagina’s hebt, voeg dan de noindex meta robots-tag toe aan alle dubbele pagina’s, behalve degene die u geïndexeerd wilt hebben.

Dit zijn pagina’s waarvan robots.txt het crawlen door Google blokkeert. Het is de moeite waard deze fouten dubbel te controleren om er zeker van te zijn, dat wat u blokkeert, moet worden geblokkeerd. Als het allemaal goed is? Dan doet robots.txt zijn werk en hoeft u zich nergens zorgen over te maken.

De pagina maakt deel uit van een set dubbele pagina’s en bevat geen canonieke URL. In dit geval is het vrij eenvoudig om te zien wat er aan de hand is. We hebben daarvoor een aantal pdf-documenten. En deze pdf’s bevatten content van andere pagina’s op de site. Eerlijk gezegd, is dit geen probleem. Maar voor de zekerheid moet u uw web developer vragen deze pdf’s te blokkeren met robots.txt. Op die manier indexeert Google alleen de originele content.

Google heeft deze pagina’s gecrawld, maar heeft ze nog niet in de index opgenomen.

Alles goed. De noindex-tag doet zijn werk. Dat is dus het Index Coverage-rapport. Ik weet zeker dat u het ermee eens bent, dat Google Search Console een zeer nuttig hulpmiddel is.

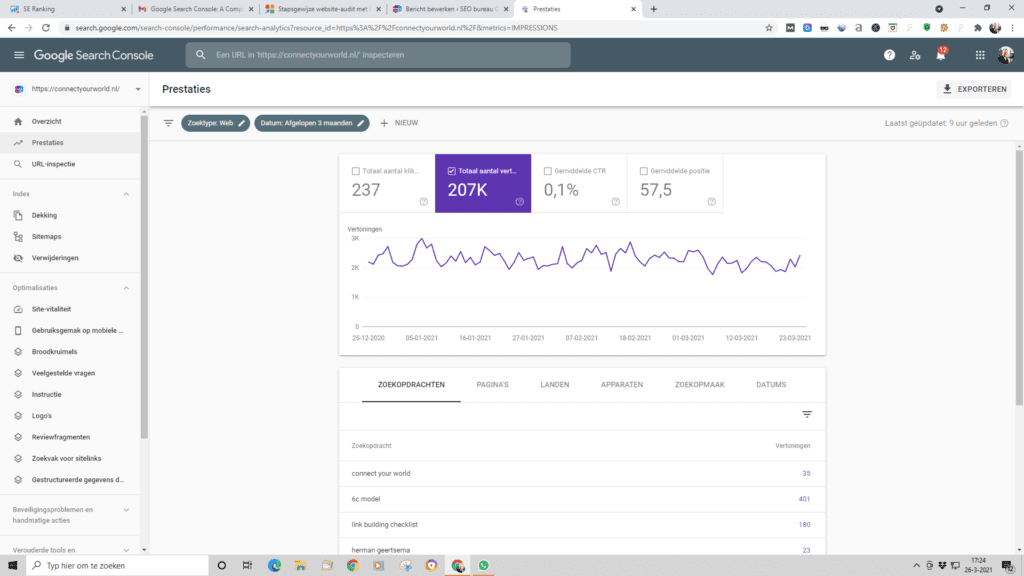

Het ‘Prestatierapport’ in Google Search Console toont u de algehele zoekprestaties van uw site in Google. Dit rapport laat u namelijk niet alleen zien hoeveel klikken u ontvangt, maar ook uw CTR en gemiddelde positie. En dit nieuwe prestatierapport vervangt het “Search Analytics” -rapport in de oude Search Console (en de oude Google Webmaster Tools). U kunt nu bijvoorbeeld coole dingen doen met de gegevens, die u krijgt, zoals bijvoorbeeld een filter om alleen AMP resultaten weer te geven.

In het oude Search Analytics rapport kon u alleen zoekgegevens van de afgelopen 90 dagen zien. Nu krijgen we maar liefst 16 maanden aan gegevens. Voor een SEO fanaat zoals wij is 16 maanden aan gegevens als het openen van cadeautjes tijdens Sinterklaas.

Core Web Vitals vertegenwoordigen:

van een pagina tijdens het laden. Idealiter wil Google, dat al uw pagina’s binnen 2,5 seconden worden geladen en interactief worden. U kunt het rapport gebruiken om te zien welke van uw webpagina’s deze benchmark met succes kunnen halen.

Zodra u het Core Web Vitals rapport opent, laat GSC u zien hoeveel van uw webpagina’s wijzigingen nodig hebben en geeft u een lijst met ontdekte problemen. Wist u, dat de Google benchmark voor paginasnelheid van 2,5 seconde voor de meeste websites moeilijk te bereiken is? In feite is de gemiddelde website snelheid op internet momenteel 18,8 seconden. Dit betekent, dat u niet zo snel hoeft te zijn als Google zegt. U hoeft alleen maar iets sneller te zijn dan uw concurrenten. Om erachter te komen, wat uw echte benchmark is, controleert u de websites van uw concurrenten met ‘Page Speed Insights’.

Het rapport over mobiel gebruiksgemak toont u de problemen die mobiele gebruikers ondervinden tijdens het gebruik van uw website. De fouten worden kort beschreven, zodat u gemakkelijk kunt begrijpen wat u moet oplossen en hoe. Voor meer inzichten klikt u op het probleem om de betrokken pagina’s te zien. Klik vervolgens op de URL, test uw pagina om alle fouten te zien en krijg handige tips om ze op te lossen.

Het lijdt geen twijfel, dat de CTR een belangrijke Google-rangschikkingsfactor is. De vraag is: Hoe kunt u uw CTR bijvoorbeeld verbeteren?

Dus laten we het prestatierapport starten in de nieuwe Search Console en aan de slag gaan.

Google Search Console houdt de huidige positie van uw zoekwoorden bij. U kunt deze inzichten gebruiken om de zoekwoorden te vinden die op het punt staan high traffic-posities in SERP in te nemen. Een kleine inspanning om deze pagina’s te optimaliseren, zal een grote bijdrage leveren aan het stimuleren van uw bezoekersaantallen.

Markeer eerst de tabbladen ‘Gemiddelde CTR’ en ‘Gemiddelde positie’: U wilt zich concentreren op pagina’s die op # 5 of lager staan … en die een slechte CTR hebben. Dus laten we de posities 1-4 eruit filteren. Om dat te doen, klikt u op de filterknop en vinkt u het vakje “Positie” aan. U ziet nu een filter vak boven de gegevens. Dus we kunnen doorgaan en dit instellen op “Groter dan” 4.9.

Nu heeft u een lijst met pagina’s die op # 5 of lager staan. Volgens Advanced Web Ranking zou positie # 5 in Google een CTR van ongeveer 4,35% moeten krijgen: U wilt alles eruit filteren, dat de verwachte CTR van 4,35% overtreft. Op die manier kunt u zich concentreren op pagina’s, die ondermaats presteren. Klik dus nogmaals op de filterknop en vink het vakje “CTR” aan. (Zorg ervoor dat u het vakje ‘Positie’ aangevinkt laat) Stel vervolgens het CTR-filter in op “Kleiner dan” 4,35. Dus wat hebben we? Een lijst met zoekwoorden die op de 5 of lager staan En een CTR hebben van minder dan 4,35%. Met andere woorden:

We moeten gewoon hun Click Through Rates (CTR) verhogen. Laten we eens kijken of we een zoekwoord kunnen vinden met een lager dan verwachte CTR. Zoek vervolgens de pagina. U wilt zien welke pagina van uw site wordt gerangschikt voor het trefwoord, dat u zojuist hebt gevonden. Om dat te doen, klikt u gewoon op de zoekopdracht met de slechte CTR. Klik vervolgens op “Pagina’s”:

Het heeft geen zin om onze CTR voor één zoekwoord te verbeteren … alleen om het te verknoeien voor tien andere zoekwoorden. Dus hier is iets heel gaafs: In het prestatierapport kunt u alle zoekwoorden zien, waarvoor uw pagina scoort. En het is eenvoudig om te doen. Klik gewoon op “+ Nieuw” in de bovenste balk en klik op “pagina …”. Voer vervolgens de URL in waarvoor u vragen wilt bekijken. Bingo! U krijgt een lijst met zoekwoorden waarvoor de pagina scoort: U kunt zien, dat de pagina meer dan 42.000 keer is weergegeven in Google … maar slechts ongeveer 1.500 klikken heeft ontvangen. De CTR van deze pagina is dus over de hele linie behoorlijk slecht.

Ik heb een paar go-to-tactieken, die ik gebruik om mijn CTR te verhogen. Maar mijn favoriet is: Power Words.

‘Power woorden’ laten zien, dat iemand snel en gemakkelijk resultaten uit uw content kan halen. En ze hebben bewezen keer op keer klikken in de SERPs te trekken. Hier zijn een paar van onze favoriete ‘Power Words’ die u in uw titel en beschrijving kunt opnemen:

Wacht ten slotte minstens 10 dagen. Log dan opnieuw in. Waarom 10 dagen? Het kan enkele dagen duren, voordat Google uw pagina opnieuw indexeert. Vervolgens moet de nieuwe pagina ongeveer een week live zijn om zinvolle gegevens te krijgen. Daarmee heb ik goed nieuws: Met de nieuwe Search Console is het vergelijken van de CTR over twee datum bereiken een fluitje van een cent. Klik gewoon op het datumfilter: Selecteer het datumbereik. Ik ga de periode van 2 weken vóór de titelwijziging vergelijken met de 2 weken erna:

Het vinden van deze goudklomp zoekwoorden in het prestatierapport is een eenvoudig proces in drie stappen.

1. Stel het datumbereik in op de afgelopen 28 dagen

2. Filter het rapport om de trefwoorden met de rangschikking “Groter dan” 7.9 weer te geven

3. Sorteer tot slot op “Vertoningen”. En u krijgt een enorme lijst met “Opportunityzoekwoorden”:

Hier is wat u moet doen om die pagina’s omhoog te duwen.

Google houdt van content, die 100% van een onderwerp beslaat. Dat is waarschijnlijk de reden waarom het gemiddelde aantal woorden van een resultaat op pagina 1 1.890 woorden is . Zorg er dus voor, dat uw content groots is. Het moet alles bevatten, wat er te weten valt over uw onderwerp.

Verblijfstijd is de hoeveelheid tijd die een Google zoeker op uw pagina doorbrengt. En als u uw verblijftijd verhoogt, kunt u hogere posities behalen (dankzij RankBrain). Nu heeft u uw content al super diepgaand gemaakt. De kans is dus groot dat uw verblijftijd al solide is. Maar om het helemaal perfect te maken, voeg wat video’s toe aan uw pagina. Wistia ontdekte dat bezoekers 2,6x meer tijd besteden aan pagina’s met video. Dat is een enorm verschil. Profiteer daarvan.

Het toevoegen van een paar interne links aan uw pagina kan deze een snelle en gemakkelijke boost geven. In het volgende hoofdstuk laat ik u zien hoe u Google Search Console kunt gebruiken om uw interne linkstructuur te optimaliseren. Maar houd er voorlopig rekening mee, dat een handvol strategische interne links uw SEO rankings snel kan verbeteren

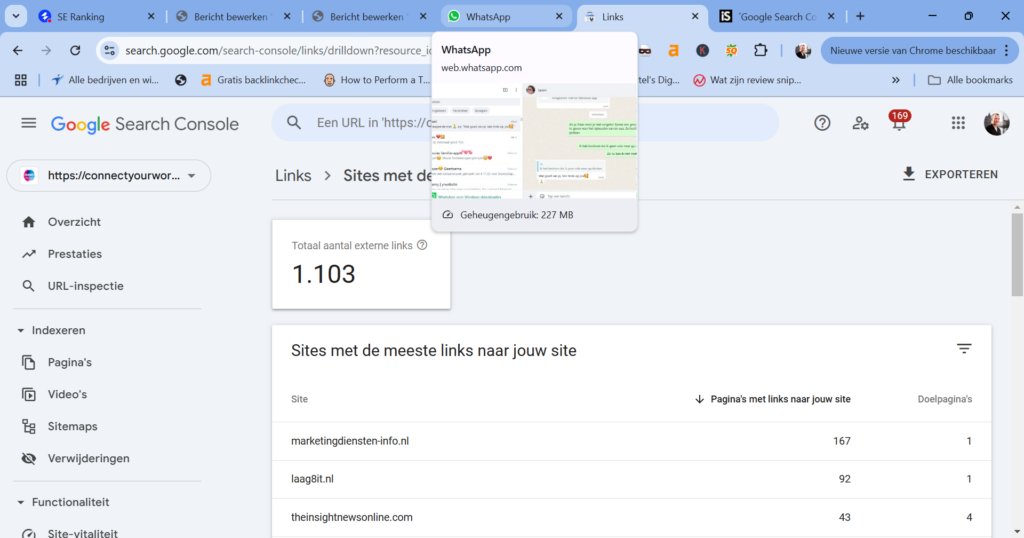

Backlinks zijn nog steeds een groot onderdeel van het algoritme van Google. Door backlinks van hoge kwaliteit naar uw pagina te bouwen, kunt u de positie verbeteren; zelfs als al het andere precies hetzelfde blijft.

U kunt Search Console gebruiken om er bijvoorbeeld achter te komen of sommige van uw fragmenten een lagere CTR hebben, dan normaal voor hun positie. Het punt is, dat elke positie in de zoekresultaten gemiddeld een bepaald percentage klikken oplevert. Als u bijvoorbeeld op positie één staat, is uw klikfrequentie waarschijnlijk rond de 30%. Als het aanzienlijk onder de 30% ligt, is er mogelijk iets mis met uw fragment.

Het is normaal dat een pagina na verloop van tijd verkeer verliest en verouderd raakt. Om erachter te komen welke pagina’s een update nodig heeft of welke verouderde content verwijderd kan worden, ga dan naar Search Console Zoekresultaten , klikt u Date > Vergelijk > Vergelijk laatste 6 maanden tot vorige periode. Schakel Klikken in en schakel over naar Pagina’s om te zien welke pagina’s de afgelopen zes maanden het meeste bezoekersverlies hebben ondervonden.

Het verkeersverlies kan een teken zijn dat er updates nodig zijn. Kijk door de pagina en controleer of de informatie nog up-to-date is, vergelijk deze met de pagina’s van concurrenten over hetzelfde onderwerp, controleer of er voldoende trefwoorden zijn, of misschien moeten titels en koppen worden geoptimaliseerd. Opmerking : het is belangrijk om het verschil te zien tussen de onderwerpen die updates nodig hebben en de onderwerpen die simpelweg hun populariteit hebben verloren. Bekijk het onderwerp van de pagina in Google Trends om te zien of het uw verdere aandacht waard is.

Het goede nieuws? U kunt nu een van uw pagina’s laten rangschikken voor honderden of zelfs duizenden longtail keywords. Ten eerste wilt u uw content super diepgaand maken. Dat hebben we al besproken. Maar het is voor herhaling vatbaar. Omdat wanneer u uitputtende content publiceert, u automatisch rangschikt voor honderden longtail zoekwoorden.

Een hint nodig over welke extra secties u moet opnemen? Controleer gewoon voor welke zoekwoorden uw pagina al scoort in Search Console.

En hier is nog een professionele tip: Vind de meest gestelde vragen die mensen over uw onderwerp stellen. Beantwoord ze vervolgens in uw content. De gemakkelijkste manier om vragen te vinden: gebruik Answer The Public .

Typ gewoon uw hoofdzoekwoord in het vak en u krijgt een enorme lijst met vragen. Het beste gedeelte? Deze antwoorden geven u een kans om te worden gerangschikt als een Featured Snippet.

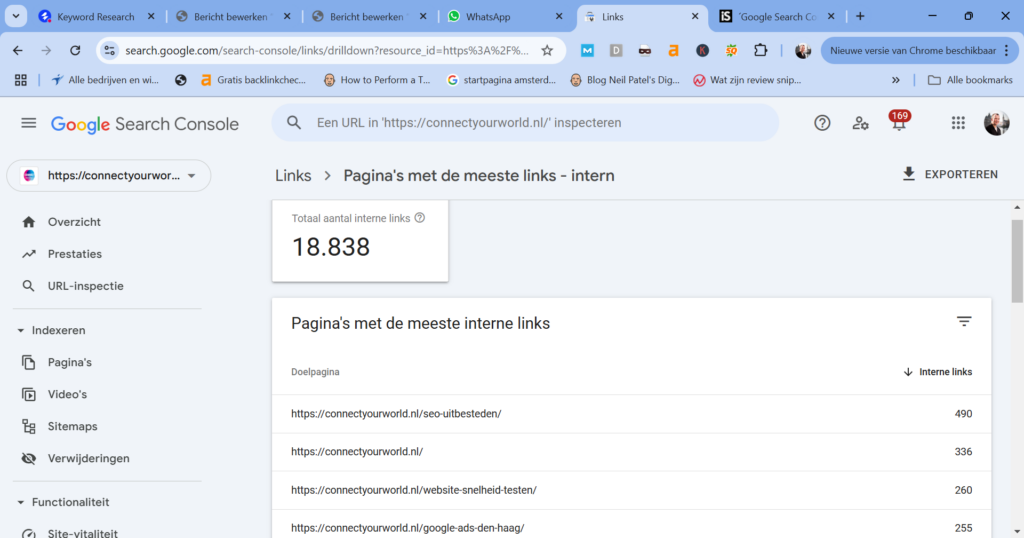

Vergis u niet! Interne links zijn super krachtig. Helaas gebruiken de meeste mensen interne links helemaal verkeerd. Dat is het slechte nieuws. Het goede nieuws is, dat Google Search Console een geweldige functie heeft, die is ontworpen om u te helpen dit probleem op te lossen. Dit rapport toont u de exacte pagina’s, die wat liefde voor interne links nodig hebben. En u krijgt een rapport met het aantal interne links, die naar elke pagina op uw site verwijzen. Het wordt nog beter. U kunt de exacte pagina’s vinden, die intern naar een specifieke pagina linken. Klik gewoon op een van de URL’s onder het gedeelte “Interne links” en u krijgt een lijst met alle interne links, die naar die pagina verwijzen.

Wat is een Powerhouse-pagina? Het is een pagina op uw site met veel hoogwaardige backlinks.

Meer backlinks = meer link juice om door te geven via interne links.

U kunt Powerhouse Pages gemakkelijk vinden in de Google Search Console. Druk gewoon nogmaals op de knop “Links”. En je ziet een sectie met de titel “Top gelinkte pagina’s”. Klik op “Meer” voor een volledige lijst. Standaard wordt het rapport gerangschikt op het totale aantal backlinks. Dit zijn uw Powerhouse-pagina’s. Het enige, dat u hoeft te doen, is een aantal interne links toevoegen vanaf die pagina’s naar degene, die u een boost wilt geven.

Als u een enorme website heeft is het de moeite waard om naar uw crawlbudget te kijken.

Uw crawlbudget is het aantal pagina’s op uw site, dat Google elke dag crawlt. U kunt dit nummer nog steeds zien in het oude rapport “Crawlstatistieken”.

Zeg dat u heeft 200.000 pagina’s op uw website en een crawlbudget van 2.000 pagina’s per dag. Het kan 100 dagen duren voordat Google uw site heeft gecrawld. Dus als u iets op een van uw pagina’s wijzigt, kan het maanden duren voordat Google de wijziging verwerkt. Of, als u een nieuwe pagina aan uw site toevoegt, zal het een eeuwigheid duren voordat Google deze heeft geïndexeerd. Dus wat kunt u doen om het meeste uit uw crawlbudget te halen?

Dit is een groot probleem voor e-commerce sites. De meeste e-commercesites laten hun gebruikers door producten filteren … en zoeken naar dingen. Dit is geweldig voor de verkoop. Maar als u niet oppast, kunt u zichzelf vinden met duizenden extra pagina’s, die er als volgt uitzien:

uwwinkel.com/product-category/?size=small&orderby=price&color=red …

Tenzij u actie onderneemt, verspilt Google graag uw crawlbudget aan deze ongewenste pagina’s. Wat is de oplossing? URL-parameters. Om deze in te stellen, klikt u op de link “URL-parameters” in de oude GSC. Klik vervolgens op “Parameter toevoegen”. Stel, dat u gebruikers producten op kleur laat filteren. En elke kleur heeft zijn eigen URL De kleur-URL’s zien er bijvoorbeeld als volgt uit:

uwwinkel.com/product-categorie/? kleur = rood

U kunt Google gemakkelijk vertellen om geen URL’s te crawlen met die kleurparameter: Herhaal dit voor alle parameters, die Google niet mag crawlen. En als u een beetje nieuw bent met SEO, neem dan contact op met een SEO specialist om er zeker van te zijn, dat dit correct wordt geïmplementeerd. Als het om parameters gaat, is het gemakkelijk om meer kwaad dan goed te doen.

Het crawlrapport in Search Console toont u de gemiddelde tijd die Google nodig heeft om uw pagina’s te downloaden: Ziet u die piek? Het betekent, dat Google ineens veel langer nodig had om alles te downloaden. En dit kan uw crawlbudget de nek omdraaien.

“Door een site sneller te maken, wordt de gebruikerservaring verbeterd en wordt de crawlsnelheid verhoogd. Voor Googlebot is een snelle site een teken van gezonde servers, zodat deze meer content kan krijgen via hetzelfde aantal verbindingen. Aan de andere kant signaleren een aanzienlijk aantal 5xx-fouten of verbindings time-outs het tegenovergestelde, en het crawlen vertraagt. “

Samengevat; zorg ervoor, dat uw site super snel laadt. U weet al, dat dit uw SEO rankings kan helpen. Het blijkt, dat een snel ladende website ook meer uit uw crawlbudget haalt.

Alsof backlinks niet meer geweldig kunnen zijn, blijkt dat ze ook helpen met uw crawlbudget. Volgens Matt Cutts is:

“De beste manier om erover na te denken, is dat het aantal pagina’s dat we crawlen ongeveer evenredig is met uw PageRank. Dus als u veel inkomende links op uw root pagina heeft, zullen we die zeker crawlen. Dan kan uw root-pagina linken naar andere pagina’s, en die krijgen PageRank en we crawlen die ook. Naarmate u echter steeds dieper op uw site komt, neemt de PageRank af. “

Meer backlinks = groter crawlbudget.

De URL inspectietool hebben wij eerder behandeld. Maar dat was een onderdeel van een groot proces. Laten we dus eens kijken naar URL-inspectie als een zelfstandige tool. In het bijzonder laten we uw 3 coole dingen zien, die u kunt doen met de Fetch As Google tool.

URL-inspectie is de snelste manier om nieuwe pagina’s geïndexeerd te krijgen. Net een nieuwe pagina gepubliceerd? Plaats gewoon de URL in het vak en druk op Enter. Klik vervolgens op “Indexering aanvragen” Google indexeert uw pagina normaal gesproken binnen een paar minuten.

Als u meer content heeft gelezen op de website van Connect your World, weet u, dat wij er dol op zijn om oude content bij te werken. We doen onze best om onze content vers te houden. Maar we doen het ook, omdat het organisch verkeer verhoogt.

Dus wat kan de “URL-inspectie” tool nog meer doen? “Test Live URL” laat zien hoe Google en gebruikers uw pagina zien. U hoeft alleen maar op de knop “Geteste pagina bekijken” te klikken. Klik vervolgens op “Screenshot”. En u zult precies zien hoe Google uw pagina ziet.

Zoals u misschien heeft gehoord, zoeken meer mensen met hun mobiele apparaten dan met desktops. Deze kloof wordt elke dag groter. De ‘Mobile-First’-index Google betekent, dat Google alleen geeft om de mobiele versie van uw site. Kort gezegd – De content en UX van uw site moeten 100% geoptimaliseerd zijn voor mobiel. Maar hoe weet u of Google uw site als mobiel geoptimaliseerd beschouwt? Welnu, de Google Search Console heeft een uitstekend rapport met de naam “Mobiele bruikbaarheid”. Dit rapport geeft aan of mobiele gebruikers problemen hebben met het gebruik van uw site.

Hier is een voorbeeld:

Zoals u kunt zien, vertelt het rapport ons over twee problemen met mobiel gebruiksgemak: “Tekst te klein om te lezen” en “Klikbare elementen te dicht bij elkaar”. Het enige dat u hoeft te doen, is op een van de problemen klikken. En het SGR zal u laten zien:

1. Pagina’s met dit probleem.

2. Hoe u het probleem kunt oplossen

Dan is het gewoon een kwestie van dat probleem oplossen.

Met het nieuwe prestatierapport kunt u eenvoudig de CTR voor mobiel en desktop vergelijken.

Hier is hoe:

Start het prestatierapport. Druk vervolgens op “Nieuw +” om een nieuw filter toe te voegen en selecteer “Apparaat”. Klik op het vergelijkingstabblad in de pop-up, selecteer ‘Desktop versus mobiel’ en klik op Toepassen. U krijgt een lijst met zoekopdrachten, met aparte statistieken voor mobiel en desktop.

Het is natuurlijk normaal, dat de conversies voor mobiele apparaten en desktops een beetje verschillen. Maar als u een groot verschil ziet, kan het zijn, dat u title- en description-tags mobiele zoekers niet aanspreken. En dat is iets dat u zou willen oplossen.

Door het toevoegen van structured data, kunt u Google nog beter vertellen, wat voor content er op uw website staat. Het wordt daardoor nog makkelijker om uw website te indexeren en te ranken ten opzichte van concurrenten. Google Search Console bevat ‘Het rapport ‘Gestructureerde gegevens’ kan niet worden geparseerd. Dit rapport toont namelijk gestructureerde gegevens (structured data), die op uw site zijn gevonden en die niet konden worden geparseerd vanwege een ernstige syntaxisfout.

Het beoogde type gestructureerde gegevens (vacature, evenement, enzovoort) kan niet worden bepaald vanwege de parseerfout. Alle items in dit rapport zijn fouten voor gestructureerde gegevens. Er zijn geen waarschuwingen of geldige items. Fouten worden automatisch gesorteerd op hoe ernstig ze zijn, zoals bepaald door het aantal getroffen pagina’s en andere factoren.

Google Search Console geeft feedback over uitgebreide resultaten via het prestatierapport. Het is een van de zes dimensies, die worden genoemd onder de grafiek, die bovenaan de pagina wordt weergegeven als ´Zoekweergave´. Als u de tabbladen ´Zoekweergave´ kiest, worden gegevens over klikken en vertoningen weergegeven voor de verschillende soorten uitgebreide resultaten, die in de zoekresultaten worden weergegeven.

Dit rapport geeft aan hoe belangrijk verkeer met rijke resultaten is naar de website en kan helpen bij het vaststellen van de reden voor specifieke trends in websiteverkeer. Het rapport ´Zoekweergave´ kan helpen bij het onderzoeken van problemen met betrekking tot gestructureerde gegevens. Een daling van het verkeer met uitgebreide resultaten kan bijvoorbeeld een signaal zijn, dat Google de vereisten voor gestructureerde gegevens heeft gewijzigd en dat de gestructureerde gegevens moeten worden bijgewerkt. Het is een startpunt voor het diagnosticeren van een verandering in verkeerspatronen met rijke resultaten. Wilt u meer weten over Technische SEO? Lees dan onze checklist!

Herman Geertsema is de eigenaar van Connect your World, een SEO en Content marketing bureau in Den Haag. Hij is een ervaren SEO consultant en Content Marketeer.

Bij Connect your World kunt u ook een SEO specialist inhuren in de volgende regio´s:

Heeft u een vraag over Google Search Console? Of wilt u ons als online marketing expert inhuren? Neem dan contact met ons op.